- Michael Hohenleitner

- am

- aktualisiert 12. Januar 2025

Du möchtest wissen, warum deine Website von Google nicht gefunden wird? Möglicherweise gibt es Probleme bei der Indexierung, die Google daran hindern, deine Website in den Suchergebnissen anzuzeigen. Hier erfährst du, wie du solche Probleme erkennen und beheben kannst.

Das Wichtigste in Kürze

- Indexierung ist entscheidend: Nur indexierte Seiten werden von Google in den Suchergebnissen angezeigt.

- Überprüfe regelmäßig den Indexierungsstatus deiner Seiten in der Google Search Console.

- Nutze Sitemaps und stelle sicher, dass deine Seiten richtig indiziert werden können.

- Sei Vorsichtig beim Einsatz von JavaScript

Inhalt

Was ist die Indexierung und warum ist sie wichtig?

Indizierung ist der Prozess, bei dem Suchmaschinen wie Google Webseiten durchsuchen und die darin enthaltenen Informationen in ihrem „Index“ speichern. Dabei handelt es sich um eine riesige Datenbank, in der alle Informationen von Webseiten gespeichert werden.

Wenn jemand eine Suchanfrage in Google eingibt, durchsucht Google nicht das gesamte Internet in Echtzeit. Stattdessen wird dieser Index durchsucht, um schnell die relevantesten Ergebnisse zu finden und anzuzeigen.

Das bedeutet: Nur wenn deine Website indexiert ist, kann sie in den Suchergebnissen erscheinen. Das bedeutet mehr Sichtbarkeit, mehr Besucher und potenziell mehr Geschäft. Ohne Indexierung bleibt deine Seite im unendlichen Meer des Internets unsichtbar.

Kurz gesagt sorgt die Indexierung dafür, dass deine Website in den Suchergebnissen gefunden wird. Sie ist die Grundlage jeder SEO-Strategie und der Schlüssel zu deiner Online-Sichtbarkeit.

Wie Suchmaschinen Webseiten indexieren

🤔 Muss ich meine Website bei Google anmelden?

Nein. Google ist in der Lage, fast alle Websites selbständig zu finden. Durch Verlinkung bereits indexierter Seiten oder durch Hinterlegung einer XML-Sitemap in der Google Search Console kann der Prozess jedoch beschleunigt werden.

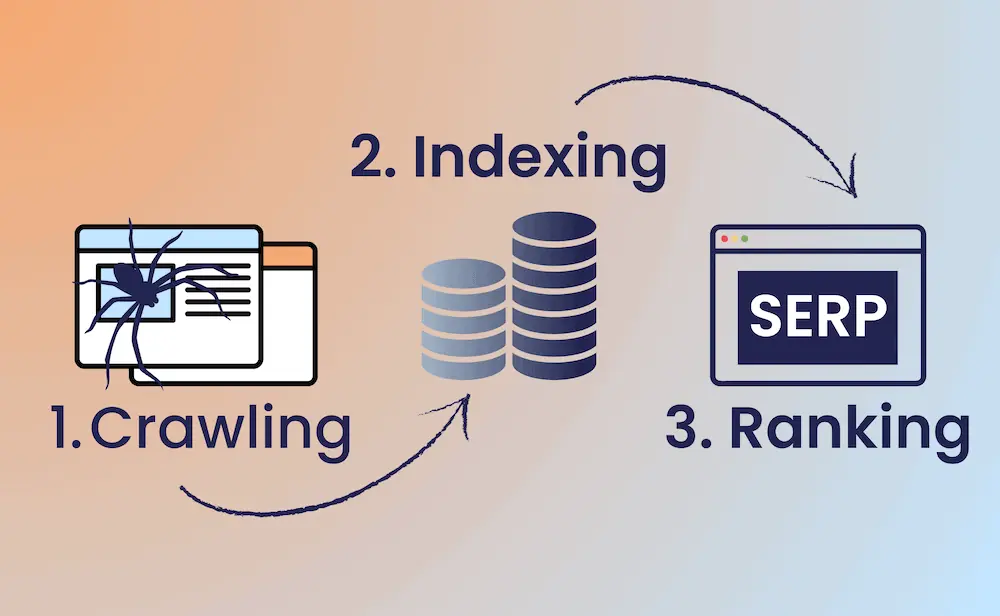

Die Indizierung von Webseiten durch Suchmaschinen kann vereinfacht in drei Phasen unterteilt werden:

- Crawling: Suchmaschinen verwenden sogenannte „Crawler“ oder „Bots“, um das Internet zu durchsuchen. Diese Bots folgen Links von einer Webseite zur nächsten und sammeln Daten über jede Seite.

- Analyse des Inhalts: Nachdem die Bots eine Seite gefunden haben, analysieren sie den Inhalt. Dazu gehören Texte, Bilder, Videos und andere multimediale Elemente. Dabei wird auch geprüft, ob die betreffende Seite überhaupt zur Indexierung freigegeben ist.

- Aufnahme in den Index: Nach der Analyse wird der Inhalt der Seite in den Index der Suchmaschine aufgenommen. Ab diesem Zeitpunkt kann die Seite über die Google-Suche gefunden werden.

Überprüfung des Indexierungsstatus

Die Überprüfung des Indexierungsstatus der eigenen Website ist ein wichtiger Schritt, um sicherzustellen, dass die eigenen Inhalte in den Suchergebnissen erscheinen. Es gibt zwei Möglichkeiten, den Indexierungsstatus zu überprüfen, je nachdem, welches Problem vorliegt:

- Du möchtest wissen, ob eine bestimmte Seite von dir indexiert ist

- Du möchtest einen Überblick bekommen, wie es um den Indexierungsstatus deiner gesamten Website bestellt ist.

Prüfen, ob eine bestimmte URL indexiert ist

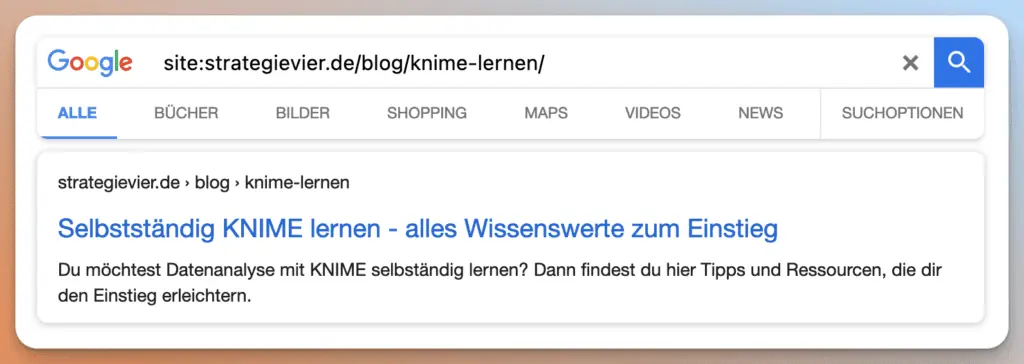

Verwendung der Site-Abfrage in der Google-Suche:

Dies ist ein schneller und einfacher Weg, um zu sehen, welche Seiten Ihrer Website von Google indexiert wurden.

- Gehe zu Google und gib in das Suchfeld „site:“ gefolgt von der URL ein, deren Indexierungsstatus du überprüfen möchtest. Zum Beispiel: „site:meinedomain.de“.

- Wenn Google die gesuchte URL anzeigt: Die Seite ist indexiert.

⚠️ Deine Startseite ist nicht indexiert?

Gary Illyes, ein Mitarbeiter von Google, betonte, dass Google sich sehr bemüht, die Startseite einer Website zu indexieren. Wenn diese nicht im Index auftaucht, kann dies auf ernsthafte technische Probleme hindeuten.

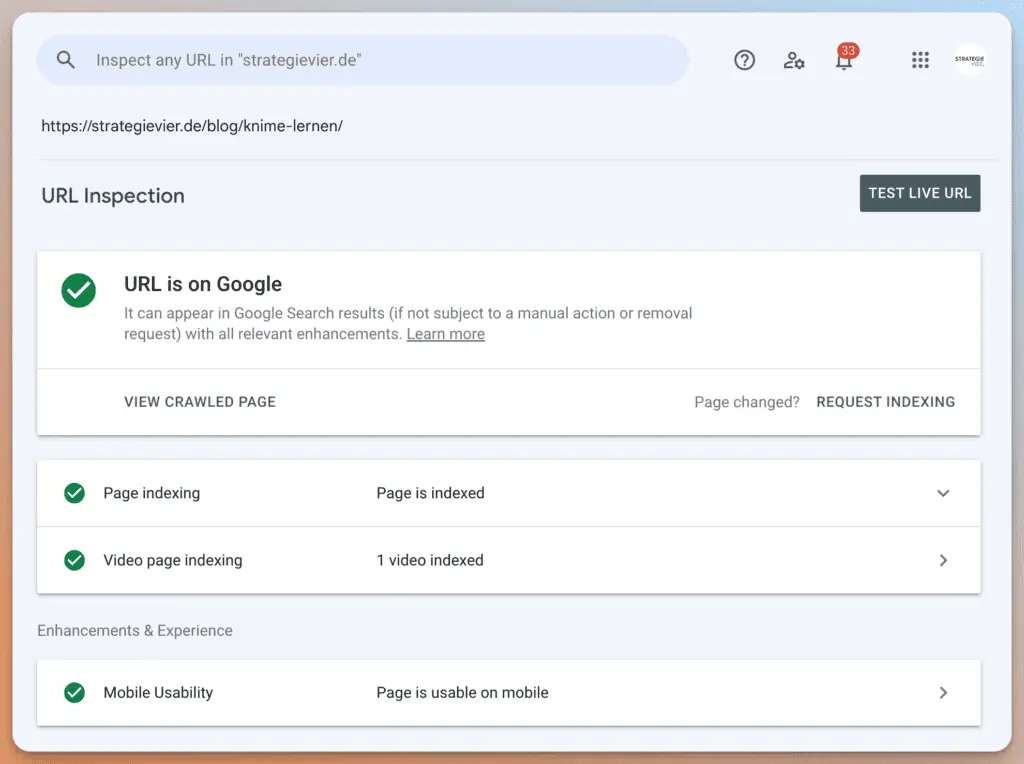

Verwendung der Google Search Console:

Die Google Search Console ist ein leistungsstarkes Tool, das detaillierte Informationen über die Indizierung und Performance deiner Website in den Google-Suchergebnissen liefert.

- Melde dich in deiner Google Search Console an und wähle deine Website aus.

- Wähle im linken Menü den Punkt „URL-Prüfung“ aus.

- Hier kannst du eine bestimmte URL deiner Website eingeben. Das Tool prüft dann den aktuellen Indexierungsstatus der Seite.

So prüfst du den Indexierungsstatus für deine gesamte Website

Um herauszufinden, ob du ein Problem mit der Indexierung deiner Webseite hast, solltest du dir zunächst einen Überblick über dein URL-Inventar verschaffen. Dabei ist es wichtig, dass die Einstellungen, die das Crawling (Robots.txt) und die Indexierung deiner Website steuern (mehr dazu weiter unten), korrekt gesetzt sind. Denn: Es geht nur darum zu prüfen, ob alle URLs, die indexiert werden sollen, auch indexiert werden.

Überblick über das Inventar deiner Website verschaffen:

Um herauszufinden, wie viele Seiten deine Website hat, gibt es folgende Möglichkeiten

- Bauchgefühl: ungenau, aber manchmal ausreichend. Bei kleineren Websites weiß man oft zumindest ungefähr, wie viele Seiten indexiert werden sollten.

- XML-Sitemap: Wenn alle Einstellungen korrekt vorgenommen wurden, sind alle indizierbaren URLs auch in der XML-Sitemap enthalten. Daraus lässt sich ableiten, wie viele URLs in den Google-Index aufgenommen werden sollen.

- Website crawlen: Mit Tools wie Screaming Frog, den ahrefs Webmaster Tools oder Seorch (kostenlos) kann man seine Website wie eine Suchmaschine crawlen und sehen, wie viele indexierbare Seiten es gibt. Diese Methode ist am aufwendigsten, hat aber zwei Vorteile:

- Du siehst auch gleich, ob alle Seiten die korrekten Indexierungs-Einstellungen haben, weil auch nicht-indexierbare URLs erfasst werden

- Du erkennst, ob Seiten mangels interner Verlinkung gar nicht gefunden werden

Prüfen der Indexierung deiner Domain:

Um herauszufinden, wie viele Seiten indiziert sind, gibt es drei Möglichkeiten:

- Site-Abfrage: Gehe zu Google und gib in das Suchfeld „site:“ gefolgt von deiner Domain ein, z. B. „site:meinedomain.de“. Die Ergebnisse zeigen alle Seiten deiner Website, die Google indexiert hat. Wenn die Anzahl der indexierten URLs (zumindest ungefähr) mit der Anzahl der indexierbaren Seiten deiner Domain übereinstimmt, ist alles im grünen Bereich.

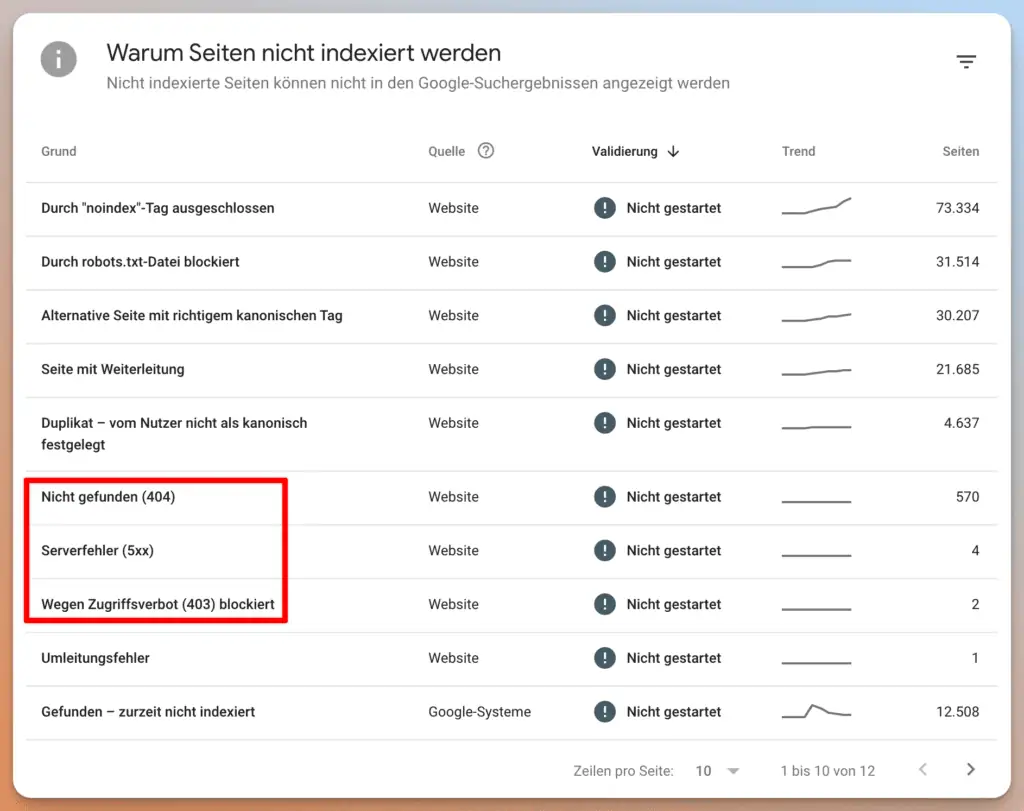

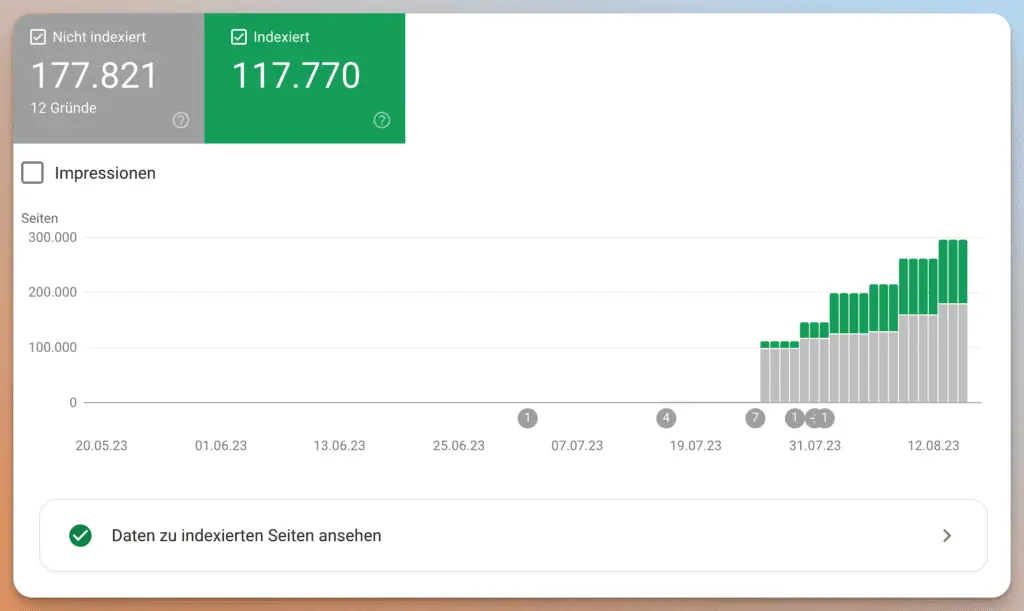

- Indexierungsbericht in der Google Search Console: Im linken Menü der Search Console findest du unter „Abdeckung“ den Indexierungsbericht. Dieser Bericht zeigt an, welche Seiten indexiert wurden und welche nicht. Er gibt auch Auskunft darüber, warum bestimmte Seiten nicht indexiert wurden, z. B. aufgrund von Crawling-Fehlern oder Sperrungen.

- Search Console URL Inspection API: Die effizienteste Methode, den Indexierungsstatus mehrerer URLs zu ermitteln, ist jedoch die URL Inspection API. Diese kannst du über das kostenlose Tool https://valentin.app/inspect.html abfragen. Wähle dazu einfach deine Search Console Property aus und füge die URLs hinzu, deren Status du überprüfen möchtest. Bitte beachte, dass die Abfrage von Google auf 2.000 URLs pro Tag beschränkt ist.

Nun, da du den Indexierungsstatus deiner Website kennst, kommen wir zu den Methoden, mit denen du die Indexierung verbessern kannst.

So verbesserst du die Indexierung deiner Website

Um sicherzustellen, dass deine Website optimal von Suchmaschinen indexiert wird, gibt es verschiedene Strategien und Tools, die du verwenden kannst. Hier sind einige Schritte, die du unternehmen kannst, um die Indexierung deiner Website zu verbessern:

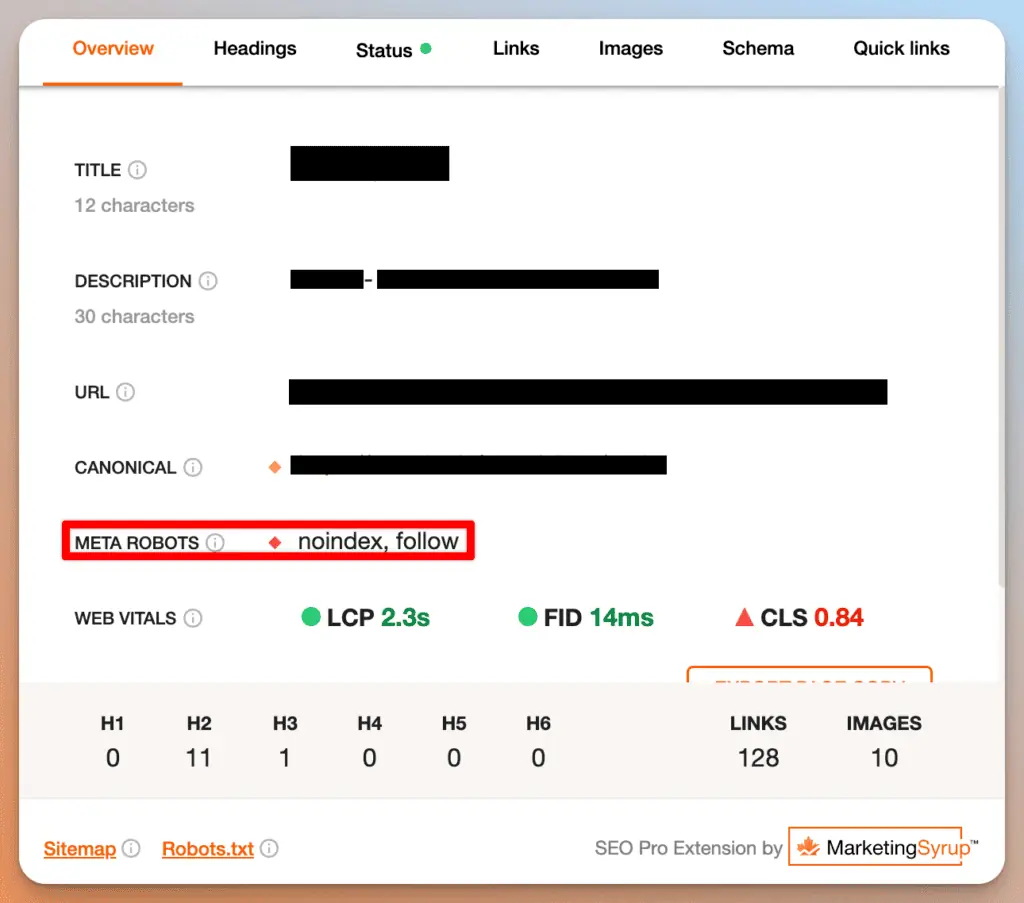

Prüfe deine Indexierungsregeln

- Warum ist das wichtig? Mit Angaben wie „noindex“ können Seiten bewusst von der Indexierung durch Suchmaschinen ausgeschlossen werden. Sind diese Angaben unbewusst gesetzt, können sie die Indexierung einzelner Unterseiten oder der gesamten Domain verhindern.

- Was kannst du tun? Benutze ein Browser Add-on, das dir anzeigt, ob die Seite, die du gerade besuchst, indexierbar ist. Ich empfehle das Add-on SEO Pro, das nicht nur anzeigt, ob eine Seite indexierbar ist, sondern auch viele weitere Informationen liefert.

Einreichung einer Sitemap über Google Search Console

- Was ist eine Sitemap? Eine Sitemap ist eine XML-Datei, die alle URLs einer Website auflistet und Suchmaschinen darüber informiert, welche Seiten auf der Website verfügbar sind.

- Wie verbessert es die Indexierung? Indem du eine Sitemap in der Google Search Console hinterlegst, gibst du Google eine klare Struktur deiner Website. Dies hilft den Bots, die Inhalte effizienter zu crawlen und zu indexieren.

- So geht’s: Melde dich in der Google Search Console an, gehe zu „Sitemaps“ und füge den Link zu deiner Sitemap hinzu. Nach dem Einreichen wird Google beginnen, deine Sitemap zu durchsuchen.

Für einzelne URLs: Verwendung der „URL überprüfen“-Funktion in der Google Search Console

„Diese praktische Funktion verwende ich immer dann, wenn ich eine bestehende Seite überarbeite oder eine neue Seite erstelle. So kann ich sicherstellen, dass die Inhalte schnell indexiert werden.„

„Diese praktische Funktion verwende ich immer dann, wenn ich eine bestehende Seite überarbeite oder eine neue Seite erstelle. So kann ich sicherstellen, dass die Inhalte schnell indexiert werden.„

- Wie verbessert es die Indexierung? Wenn du wichtige Seiten hast, die du schnell indizieren möchtest, kannst du diese Funktion nutzen.

- So geht’s: Im Dashboard der Search Console gibt es die Option „URL-Prüfung“. Hier kannst du die spezifische URL eingeben, die du überprüfen möchtest. Nach der Überprüfung hast du die Möglichkeit, die URL zur Indexierung einzureichen.

Optimierung der internen Verlinkung

- Warum ist das wichtig? Interne Links helfen Suchmaschinen, den Zusammenhang zwischen den Seiten einer Website zu verstehen und fördern das Crawling. Dabei gilt: Gut verlinkte Inhalte werden tendenziell häufiger durchsucht als selten verlinkte.

- Tipps zur Optimierung:

- Verlinke relevante Inhalte miteinander.

- Nutze aussagekräftige Ankertexte, die den Inhalt der verlinkten Seite beschreiben.

- Vermeide übermäßige interne Links; sie sollten natürlich und hilfreich für den Benutzer sein.

- Stelle sicher, dass auch ältere Inhalte über ausreichend eingehende Links verfügen

Vermeidung von Blockierungen durch die robots.txt

- Was ist robots.txt? Dabei handelt es sich um eine Datei, die Suchmaschinen mitteilt, welche Teile der Website sie nicht durchsuchen sollen.

- Warum ist es wichtig? Wenn Seiten versehentlich in der robots.txt blockiert sind, werden sie nicht indexiert.

- Was kannst du tun?

- Überprüfe regelmäßig deine robots.txt-Datei und stelle sicher, dass keine wichtigen Inhalte blockiert werden.

- In der Google Search Console kannst du den „robots.txt Tester“ verwenden, um zu sehen, wie Google deine robots.txt interpretiert und ob es Blockierungsprobleme gibt.

💡Kleiner Exkurs zur Robots.txt-Datei:

Die Robots.txt-Datei regelt nicht die Indexierung, sondern das Crawling. Das bedeutet, dass Indexierungsregeln wie ein noindex-Tag von Suchmaschinen nicht gelesen werden, wenn die URL per Robots.txt vom Crawling ausgeschlossen ist. Werden per Robots.txt gesperrte Inhalte häufig verlinkt, können sie dennoch in den Suchergebnissen erscheinen.

In den meisten Fällen ist daher die Angabe noindex die bessere Wahl, um Seiten von der Indizierung auszuschließen. Die Datei Robots.txt sollte dagegen vor allem dann verwendet werden, wenn durch das Crawling unverhältnismäßig viele URLs aufgerufen würden.

Optimiere die Qualität deiner Inhalte

- Warum ist es wichtig? Suchmaschinen haben keine Ressourcen und kein Interesse daran, Inhalte zu indexieren, deren Qualität nicht besonders hoch ist und die dem Nutzer keinen Mehrwert bieten.

- Was kannst du tun?

- Stelle sicher, dass deine Inhalte gute Qualität aufweisen und hilfreiche Informationen bieten

- Vermeide dünne Inhalte und leere Seiten den Suchmaschinen zur Indexierung anzubieten.

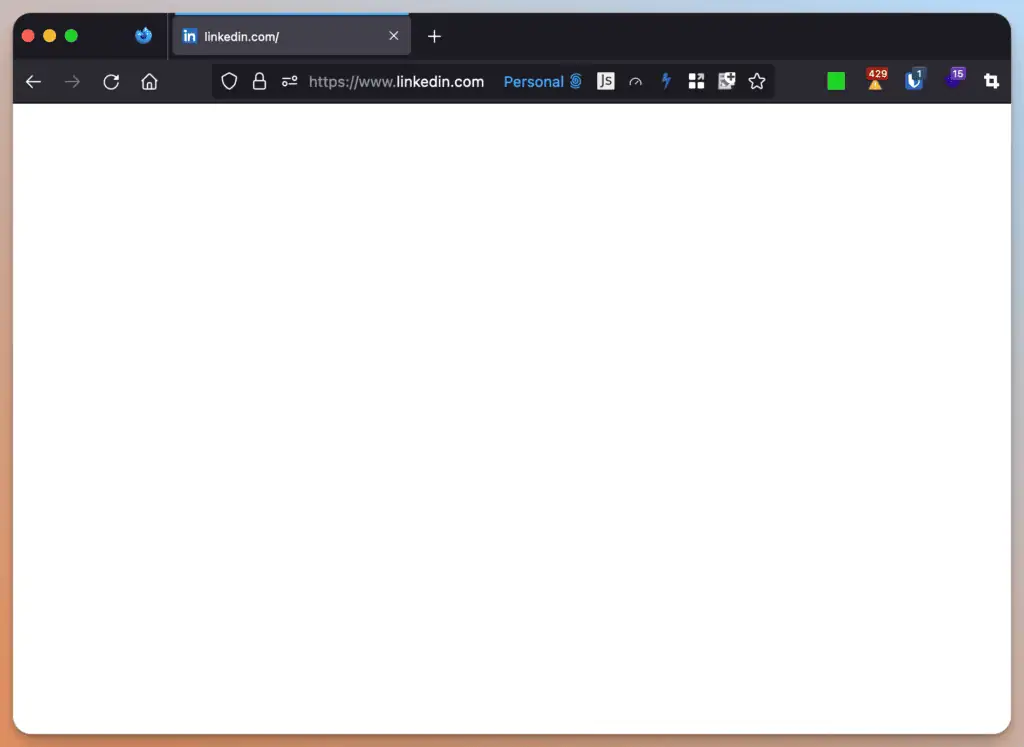

Reduziere den Einsatz von JavaScript

- Warum ist es wichtig? Google kann zwar JavaScript-Inhalte (meistens) lesen, tut es aber nicht immer, weil der Aufwand deutlich höher ist als bei „normalen“ Text-Dokumenten.

- Was kannst du tun?

- Stelle sicher, dass deine Inhalte auch ohne aktiven JavaScript sichtbar sind. Mit Browser Add-ons wie der Web-Developer Toolbar kannst du prüfen, wie deine Website ohne aktiven JavaScript aussieht.

Vermeide doppelte Inhalte

- Warum ist es wichtig? Dass Duplicate Content ein SEO-Problem ist, hat sich mittlerweile herumgesprochen. Duplicate Content kann aber auch die Indexierung von Seiten verhindern. Warum das so ist? Wie bereits weiter oben geschrieben, hat Google kein Interesse daran, Inhalte ohne Mehrwert zu indexieren. Da Duplicate Content keinen Mehrwert bietet, wird er oft nicht indexiert.

- Was kannst du tun?

- Überprüfe im Indexierungsbericht der Search Console, ob es Inhalte gibt, die mit der Meldung „Duplikat – nicht vom Nutzer als kanonisch festgelegt“ gekennzeichnet sind. Wenn es Seiten gibt, die du für wichtig hältst, gehe zum URL-Prüfungstool in der Search Console und schaue nach, welche URL von Google als Original festgelegt wurde. Dann kannst du die Duplikate auflösen (löschen und eine Variante weiterleiten oder die Inhalte in einem Dokument zusammenführen).

Sorge für schnelle Ladezeiten

- Warum ist es wichtig? Google hat keine Zeit, langsame Webseiten zu crawlen. Wenn eine Seite zu langsam ist, wird das Crawlen manchmal abgebrochen. Außerdem hängt die Ladezeit davon ab, wie viele Unterseiten Google auf deiner Domain crawlt. Schnelle Seiten = mehr Seiten werden gecrawlt.

- Was kannst du tun?

- Bilder komprimieren: Nutze Tools wie TinyPNG oder JPEG Optimizer, um die Dateigröße deiner Bilder zu reduzieren, ohne die Qualität wesentlich zu beeinträchtigen.

- Browser-Caching nutzen: Durch das Setzen von Cache-Headern können wiederkehrende Besucher Inhalte schneller laden, da bereits heruntergeladene Ressourcen im Browser-Cache gespeichert werden.

- Lazy Loading anwenden: Bilder oder Videos erst dann laden, wenn sie im Viewport des Nutzers sichtbar sind, anstatt alles beim ersten Seitenaufruf zu laden.

Verwendung der korrekten Status Codes

- Warum ist es wichtig? Suchmaschinen indexieren ausschließlich Seiten, die dem Client (Broswer, Suchmaschinen Crawler…) mit einem Status Code 200 antworten. Dieser besagt, dass das Dokument erfolgreich geladen werden konnte. Alle anderen Status Codes werden nicht indexiert.

- Was kannst du tun?

- Stelle sicher, dass deine wichtigen Seiten alle mit einem Status Code 200 antworten.

Überwachung des Indexierungsstatus

Nachdem du nun die Werkzeuge für eine gute Indexierung deiner Website kennen gelernt hast, ist es wichtig zu betonen, dass du den Indexierungsstatus deiner Website regelmäßig überprüfen solltest.

Der Indexierungsbericht in der Search Console ist dafür sehr hilfreich. Er zeigt dir nicht nur, wie viele Seiten indexiert sind, sondern auch, wie viele nicht indexiert sind und warum. Die Informationen, warum eine Seite nicht indexiert wurde, sind leider nicht immer selbsterklärend, aber ich empfehle dir, zumindest darauf zu achten, ob es in einem der Berichte signifikante Änderungen gibt.

Fazit

Ich hoffe, ich konnte dir in diesem Leitfaden einige Tipps geben, wie du die Indexierung deiner Website verbessern kannst. Wenn sich die Probleme nicht lösen lassen, solltest du ein kostenpflichtiges Tool wie Screaming Frog in Kombination mit der URL Inspection API verwenden, um zu analysieren, wo die Probleme liegen. Wir helfen dir gerne dabei. Wir freuen uns, von dir zu hören.