- Michael Hohenleitner

- am

- aktualisiert 12. Januar 2025

Du möchtest deine Google Search Console Daten dauerhaft in BigQuery archivieren, aber die Google Datenbank ist für dich eine Blackbox? Kein Problem: Wir zeigen dir detailliert, wie du ein Projekt in der Google Cloud anlegst und die Daten aus der GSC an BiqQuery schickst.

Inhalt:

Sei dem 21. Februar 2023 stellt Google allen Nutzern der Search Console eine tägliche automatische Archivierung der Search Console Daten in der Google BiqQuery Datenbank zur Verfügung. Dies vereinfacht die Archivierung der Search Console Daten erheblich und ist eine gute Möglichkeit für jeden SEO, sich ohne Programmieraufwand ein kleines Keyword-Data-Warehouse aufzubauen.

💡 Was ist BigQuery?

BigQuery ist ein von Google entwickeltes, Cloud-basiertes Analyse- und Data-Warehouse-System. Es ermöglicht den Nutzern, große Datenmengen schnell und einfach zu analysieren, indem schnelle, skalierbare Abfragen über strukturierte und unstrukturierte Daten in der Cloud ausgeführt werden. BigQuery eignet sich besonders für die Verarbeitung von Big Data, einschließlich Datensätzen in Terabyte- oder sogar Petabyte-Größe. Es verwendet eine SQL-ähnliche Abfragesprache, um Daten aus verschiedenen Quellen wie Google Cloud Storage, Google Drive, Cloud Firestore, Cloud Spanner und anderen zu extrahieren und zu analysieren.

Warum ist das wichtig?

Die Google Search Console ist eine wichtige Datenquelle für die SE-Optimierung von Websites. Leider werden die Daten dort nur 16 Monate lang gespeichert. Eine Betrachtung der Klickzahlen über einen längeren Zeitraum ist daher nicht möglich.

Außerdem sind Exporte über die Benutzeroberfläche der Search Console auf 1.000 Zeilen beschränkt, was selbst für kleine Websites oft zu wenig ist.

Mit der Möglichkeit, die Daten automatisch in BigQuery zu speichern, löst Google nicht nur das Problem der Speicherdauer, sondern ermöglicht auch Analysen und Exporte mit mehr als 1.000 Zeilen.

Hier zeigen wir dir Schritt für Schritt, wie du deine Search Console Daten automatisiert in BigQuery speichern kannst.

Zu wenig Traffic? Kaum Klicks?

Lass uns die Gründe herausfinden! Unser SEO-Consultant analysiert deine Firmen-Website und erarbeitet eine nachhaltige SEO-Strategie für euer Unternehmen.

Voraussetzungen

Um diesen Dienst zu nutzen, musst du ein Eigentümer der Search Console Property sein, die du exportieren möchtest. Zudem musst du Zugriff auf eine Kreditkarte haben. Denn:

Google BigQuery ist ein kostenpflichtiger Service. Solange deine Website nicht zu groß ist, sind die Kosten jedoch sehr gering. Wie du die Zahlungsdaten für Google Cloud Projekte einrichtest, erfährst du in Schritt 5.

Was kostet BigQuery?

Die Kosten richten sich nach der Menge der gespeicherten Daten und der Häufigkeit der Abfragen. Die Preise sind zudem nutzungsabhängig:

- Abfragepreise:

- On-Demand-Preise

- Pauschalpreise

- Speicherpreise:

- Aktiver Speicher

- Langfristiger Speicher

Stand März 2023 waren bei den On-Demand-Preisen das erste Terabyte ebenso kostenlos wie die ersten 10 GB bei den Speichern. Die aktuellen Preise findest du in der BigQuery Preisliste bei Google.

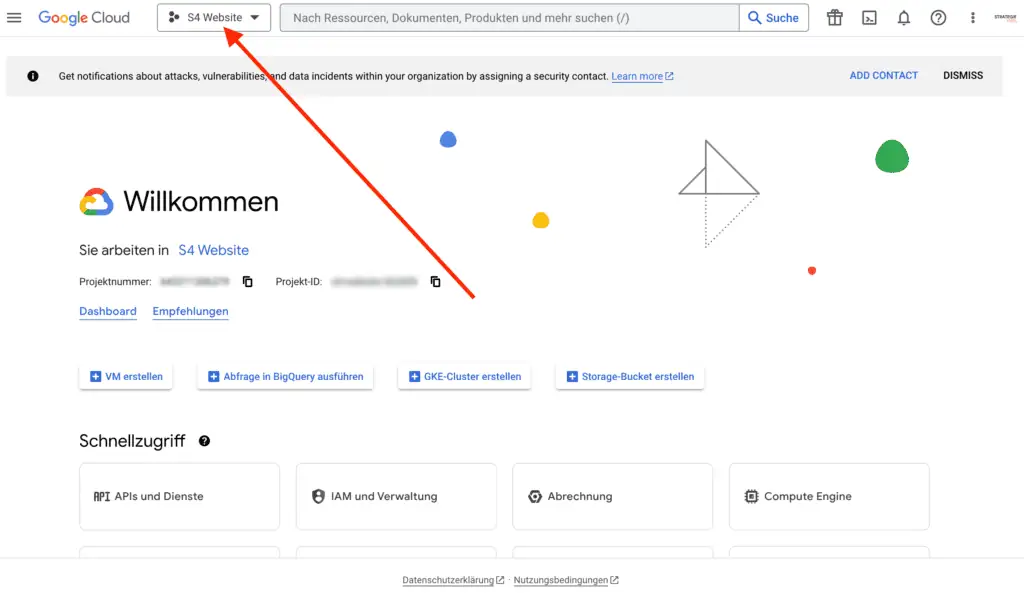

1. Ein Projekt in BigQuery anlegen

Zuerst musst du ein Projekt in BigQuery erstellen. Dazu gehst du auf die Website https://console.cloud.google.com/ und loggst dich mit deinen Google-Zugangsdaten ein (z.B. mit denen, die du auch für die Search Console verwendest).

Wähle ein bestehendes Projekt aus oder erstelle ein neues:

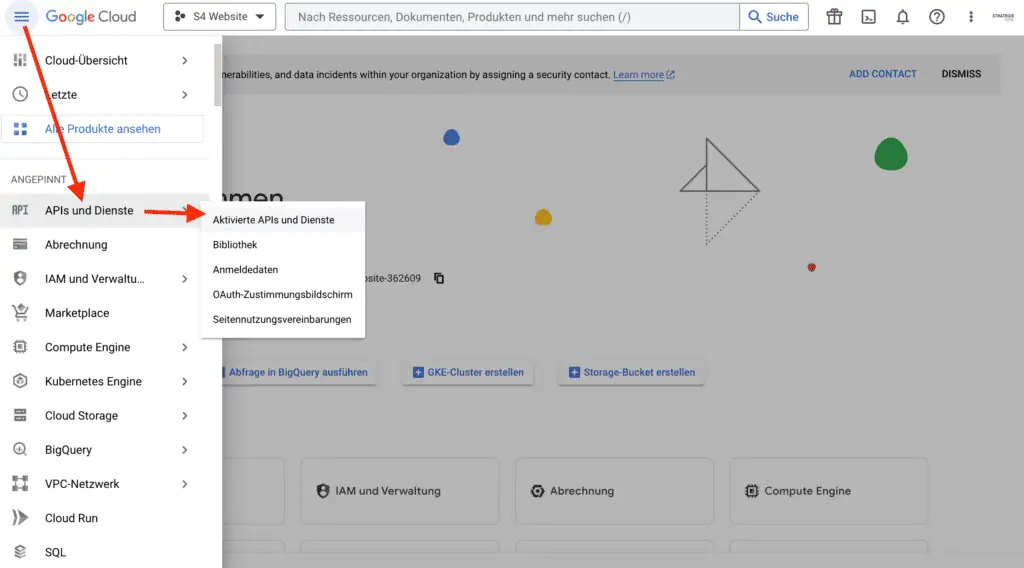

Navigiere nun im Burger-Menü oben links auf APIs und Dienste und zu Aktivierte APIs und Dienste, um die API von BigQuery zu aktivieren.

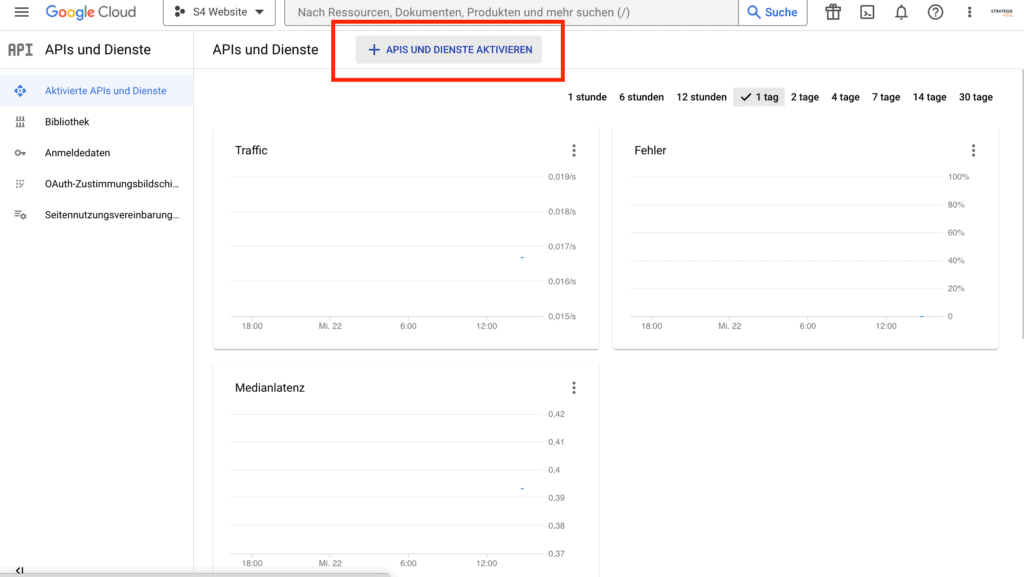

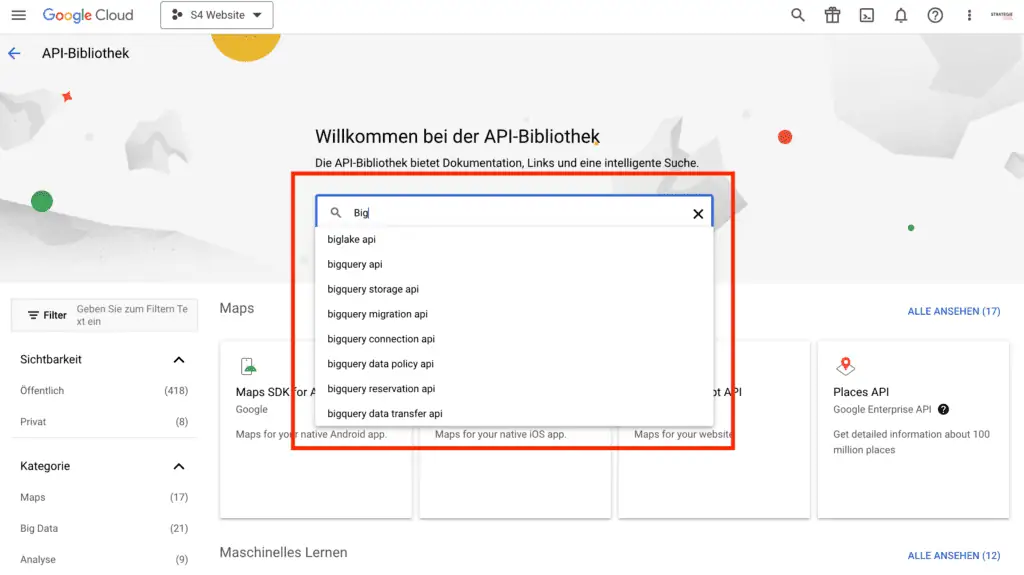

2. BigQuery API aktivieren

Auf der nun erscheinenden Seite wähle APIs und Dienste aktivieren:

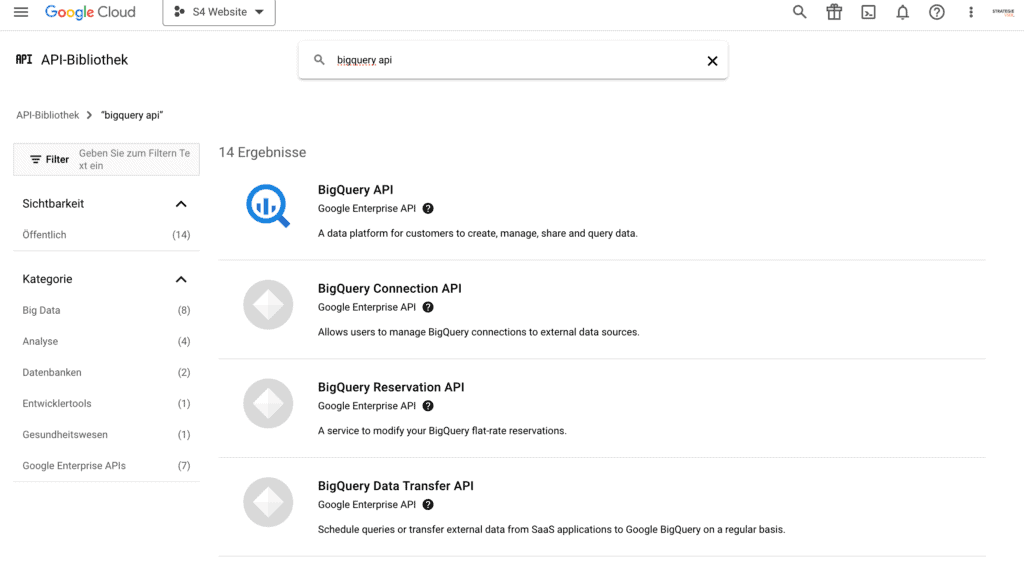

Die Seite der API-Bibliothek öffnet sich mit einem Suchfeld. Suche dort nach BigQuery API:

In den Suchergebnissen BigQuery API auswählen:

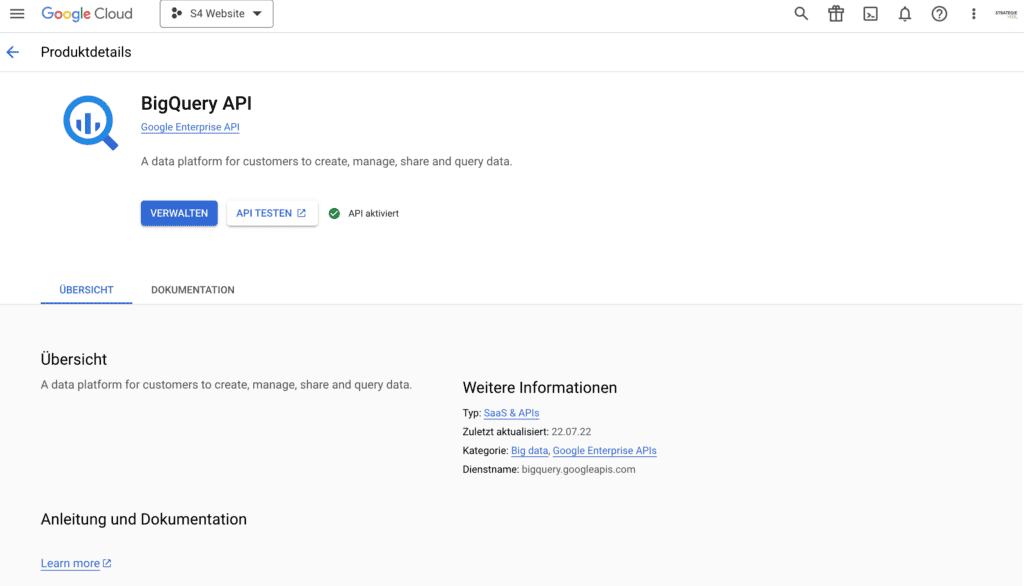

Nun muss die API aktiviert werden. Klicke auf API aktivieren, damit der grüne Haken erscheint:

3. Der Search Console Zugriff auf BigQuery ermöglichen

Damit die Search Console die Daten an BigQuery übergeben kann, muss der Console noch der Zugriff auf das Projekt gewährt werden.

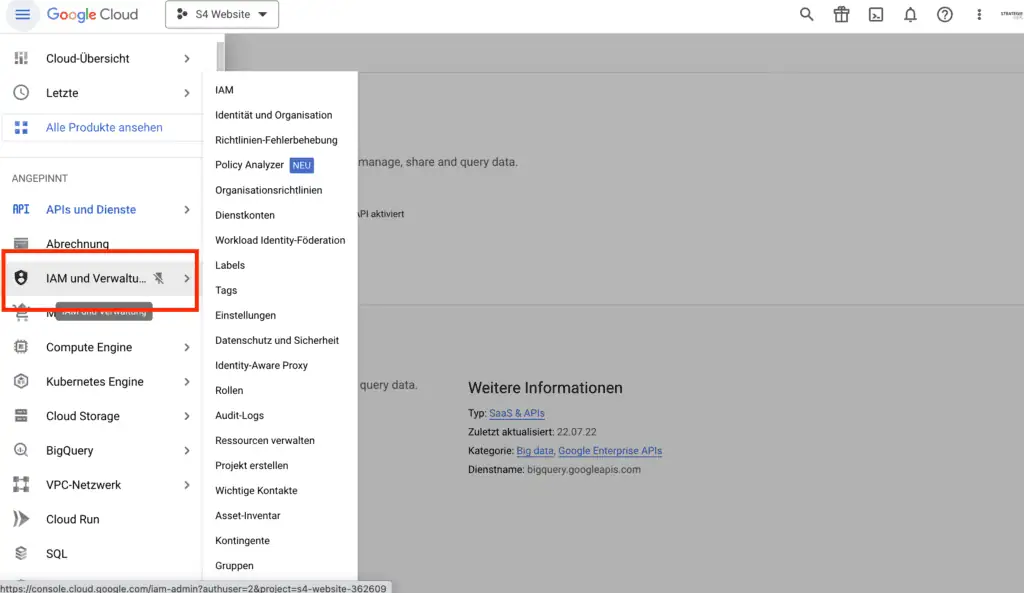

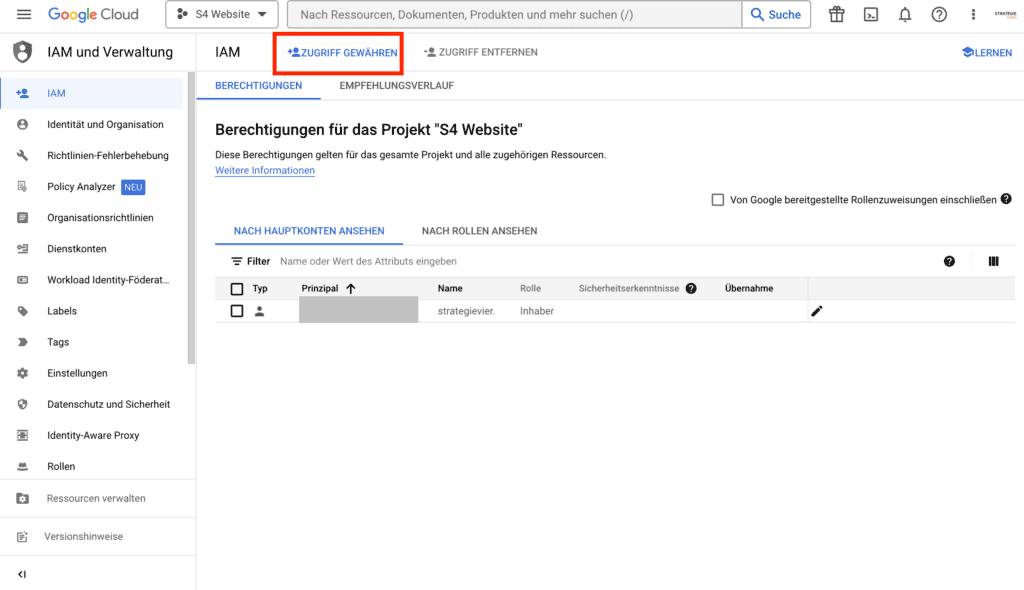

Dazu navigierst du zum Menüpunkt IAM & Verwaltung:

Dort wählst du oben den Link Zugriff gewähren aus.

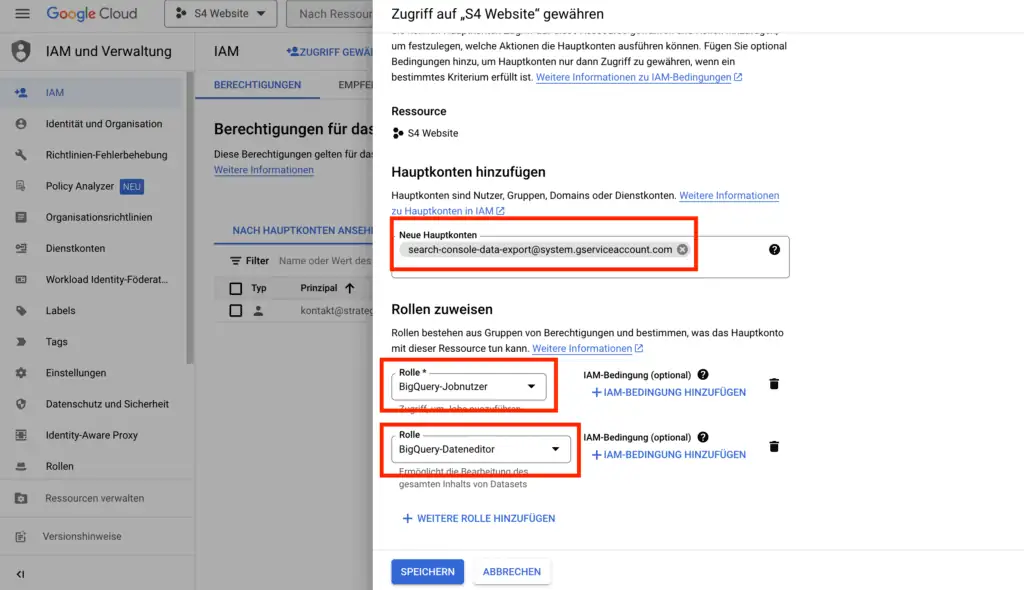

Es muss ein neues Hauptkonto hinzugefügt werden und diesem Rollen zugewiesen werden, damit die Daten von der Search Console zu BigQuery übertragen werden können.

Wichtig ist dabei, dass exakt die Daten angegeben werden, die Google vorgegeben hat:

- Hauptkonto:

search-console-data-export@system.gserviceaccount.com - Rolle 1: BigQuery-Jobnutzer

- Rolle 2: BigQuery-Dateneditor

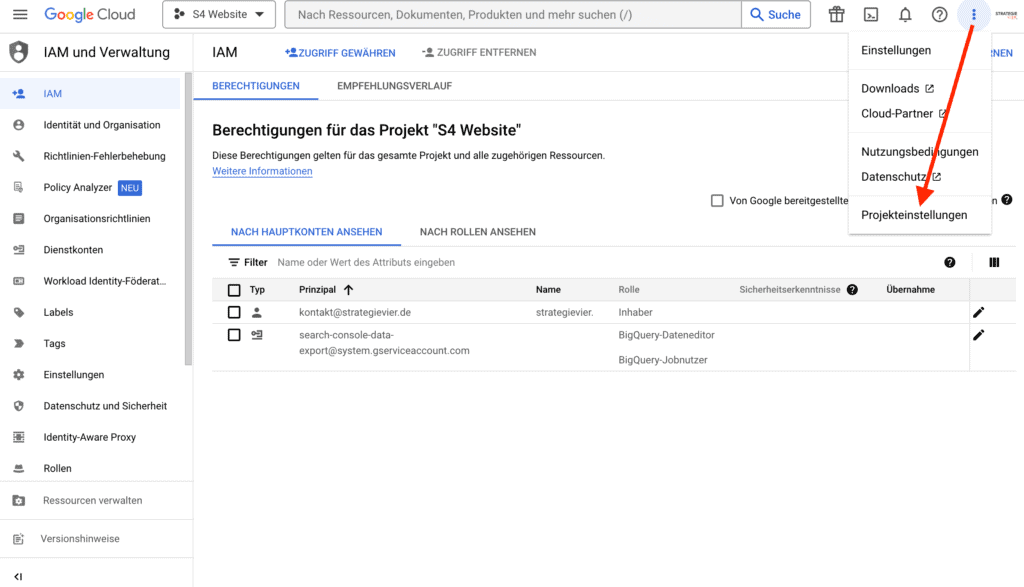

Speichere anschließend deine Eingaben. Bevor du in der Search Console weitermachst, solltest du dir deine Projekt-ID notieren. Diese findest du im Menü oben rechts unter Projekteinstellungen.

4. Bulk-Datenexport in der Search Console einrichten

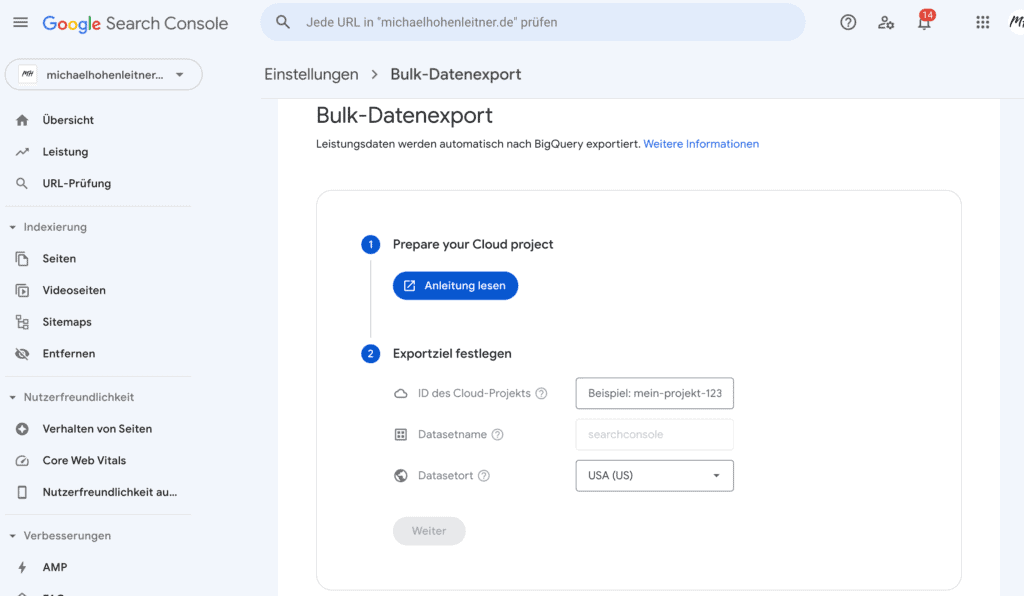

In diesem Schritt konfigurieren wir den Export zu BigQuery in der Search Console. Die Einstellungen dazu finden sich in der Search Console unter Einstellungen > Bulk-Datenexport.

Hier benötigst du nun die ID deines Cloud-Projekts (siehe oben). Diese gibst du in das entsprechende Feld ein und wählst einen Datenstandort aus. Dieser wird in der Regel „Europa“ sein.

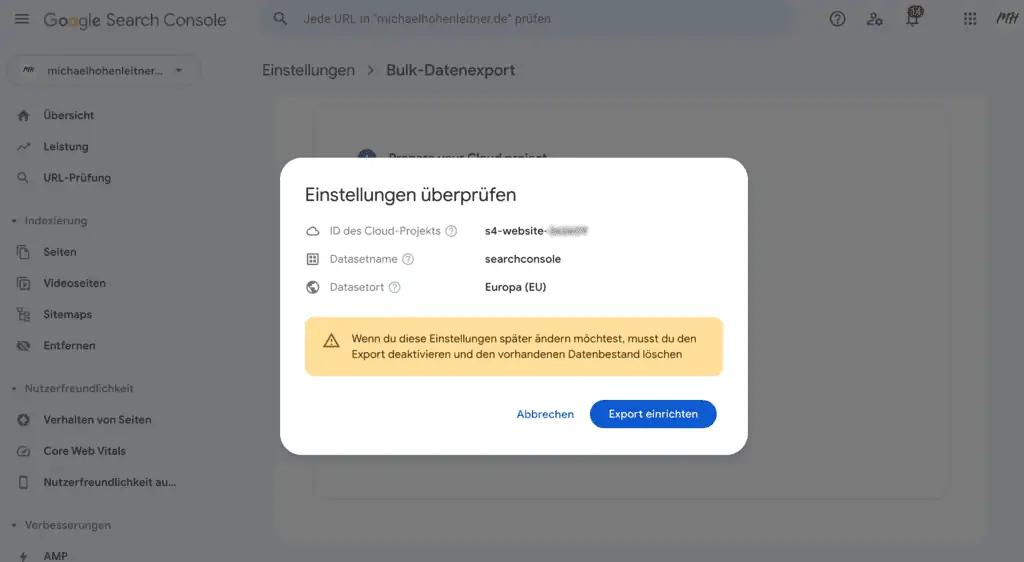

Anschließend können die Einstellungen noch einmal überprüft werden, bevor die Datenübertragung eingerichtet wird:

5. Zahlungsinformationen einrichten

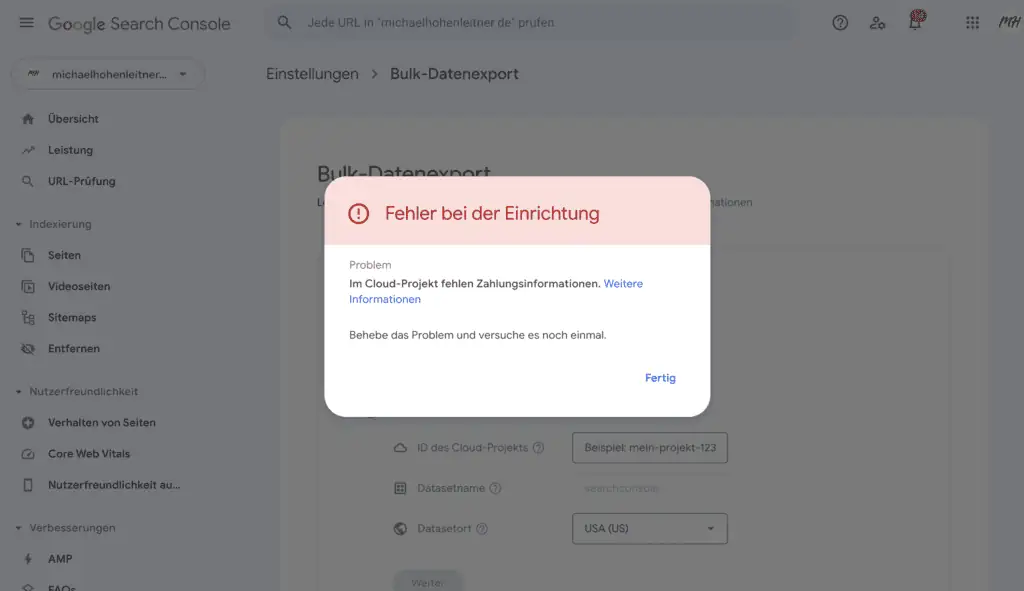

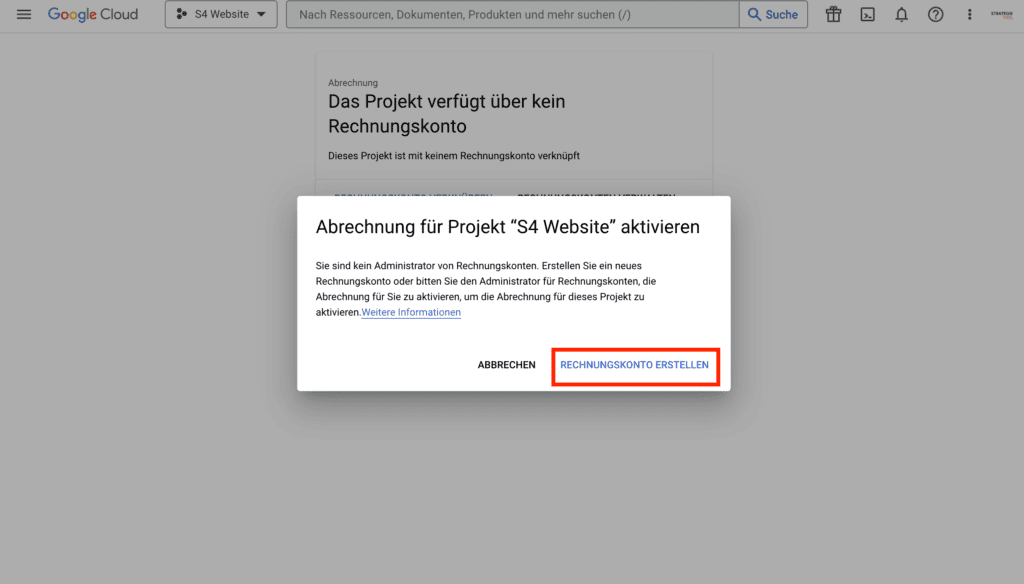

Google BigQuery ist ein kostenpflichtiger Dienst. Daher kann es sein, dass du eine Fehlermeldung erhältst, wenn du versuchst, die Datenübertragung einzurichten, da kein Zahlungskonto hinterlegt ist.

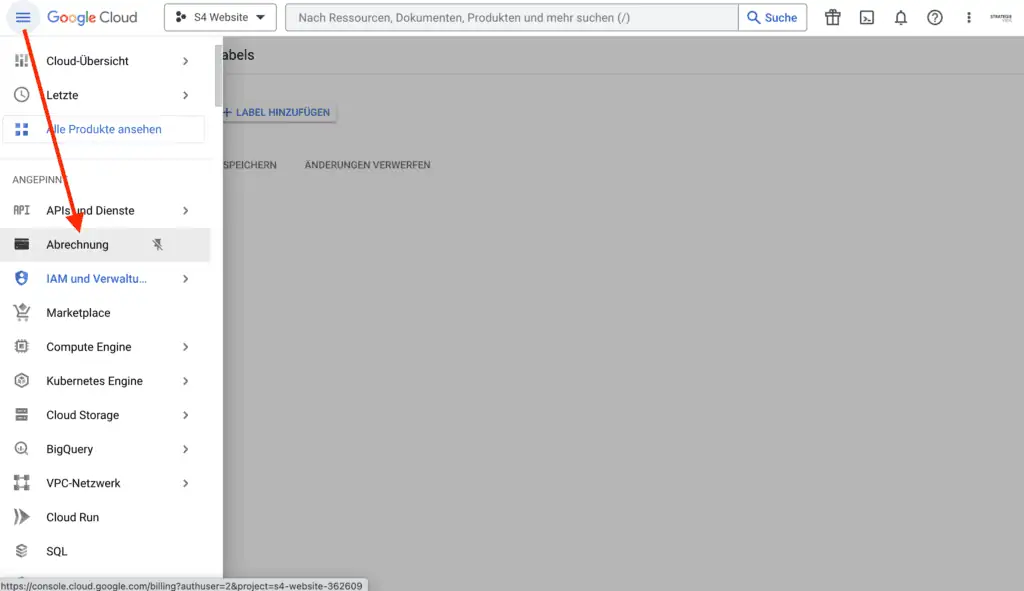

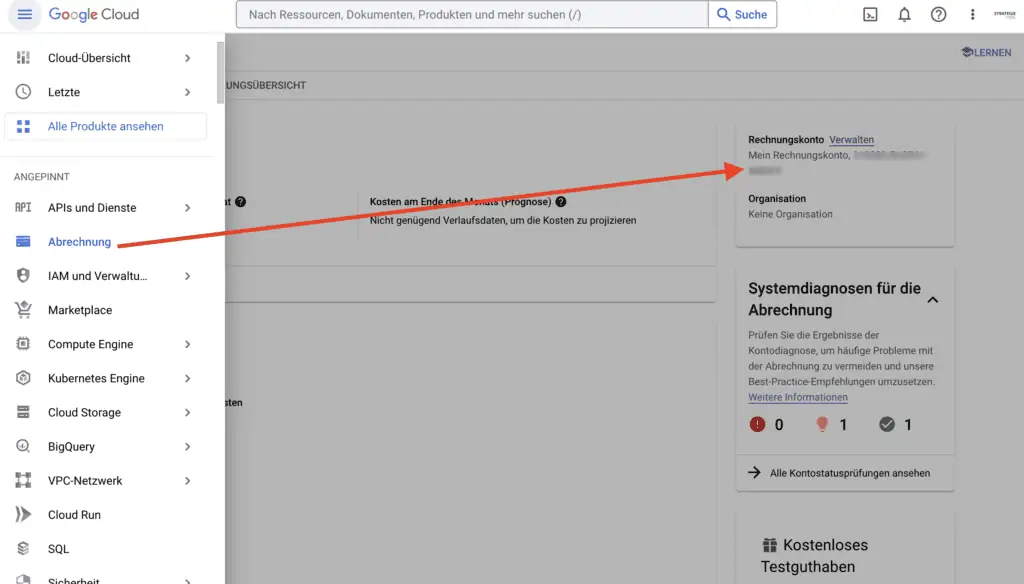

Um Zahlungsinformationen zu hinterlegen, gehe zurück zu deinem Google Cloud Projekt und wähle im Menü Abrechnung aus:

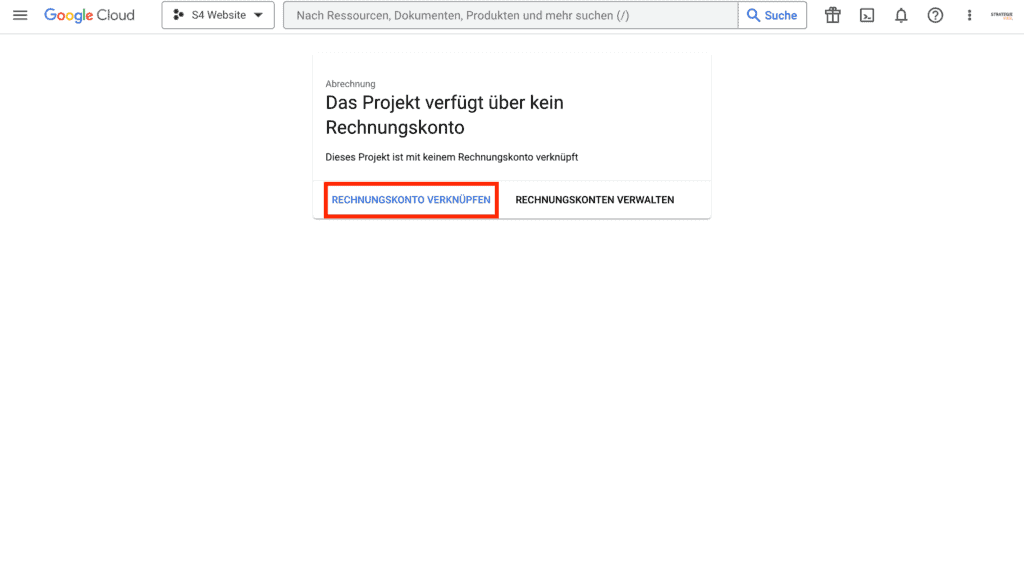

Dort wirst du darüber informiert, dass kein Rechnungskonto hinterlegt ist. Klicke dazu auf Rechnungskonto verknüpfen:

Es erscheint eine Meldung, dass ein neues Abrechnungskonto angelegt werden muss.

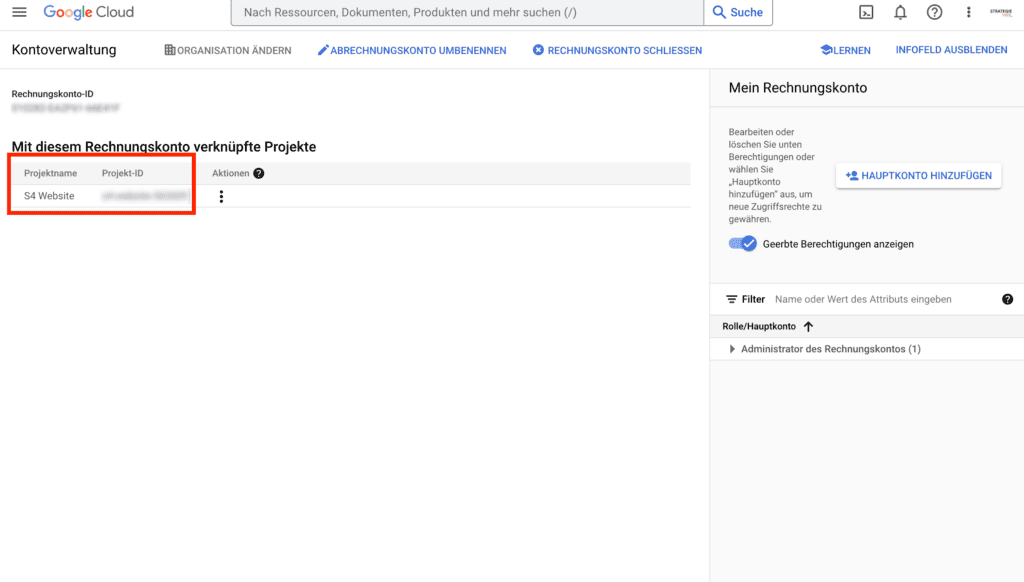

Im folgenden Prozess gibst du deine Zahlungsinformationen an. Danach muss ein Zahlungskonto mit deinem Projekt verknüpft sein. Um dies zu überprüfen, kannst du unter Zahlungskonto verwalten sehen, mit welchen Projekten dein Zahlungskonto verknüpft ist. In dieser Übersicht sollte dein Projekt (Projekt-ID) auftauchen, das du für den BiqQuery Export der Search Console angelegt hast.

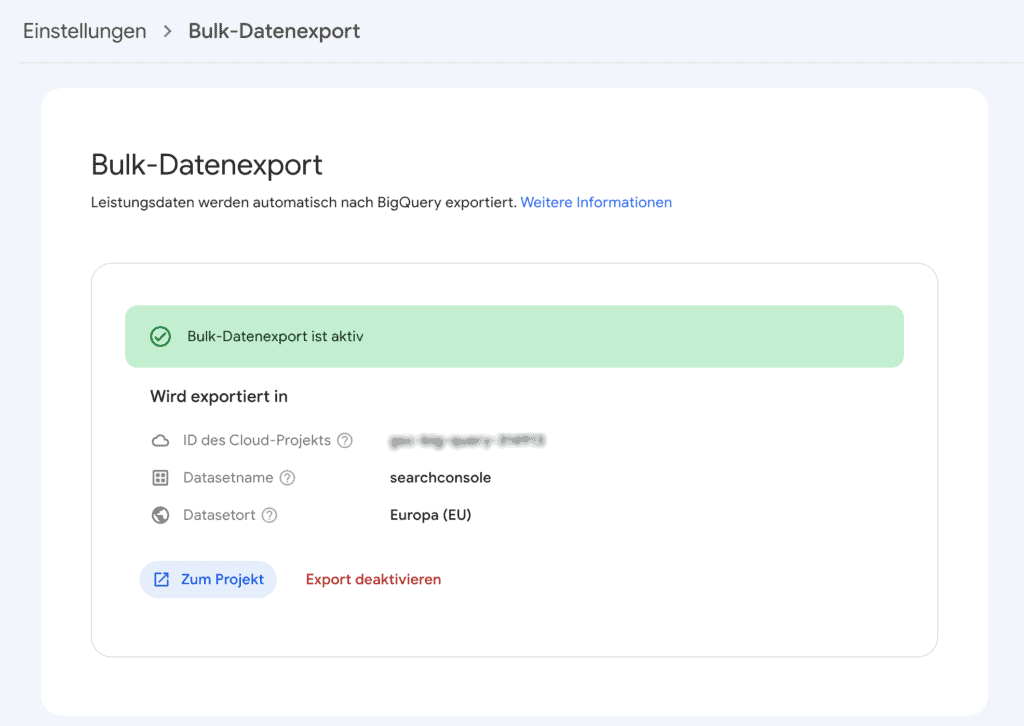

Ist das der Fall, sollte einer erfolgreichen Datenübertragung nichts mehr im Weg stehen. Gehe also zurück zur Search Console und versuche erneut den Bulk-Datenexport einzurichten, nun sollte es klappen:

Der Link Zum Projekt führt dich direkt zu Google BigQuery, wo die Daten nun gespeichert werden.

Die Daten in BigQuery

Wenn alles richtig eingerichtet ist, findest du nach 1-2 Tagen einen täglichen Export deiner Search Console Daten in BigQuery.

Es werden zwei Tabellen erstellt. Auf der Registerkarte Vorschau kann man sehen, wie die Daten aussehen:

URL-Daten

In der Tabelle searchdata_url_impression werden alle URLs und die dazugehörigen Keywords angezeigt, die mindestens eine Impression generiert haben und nicht von Google gefiltert wurden (z.B. wegen personenbezogener Daten).

Keyword-Daten

Die Tabelle searchdata_site_impression enthält nur Keyword-Daten:

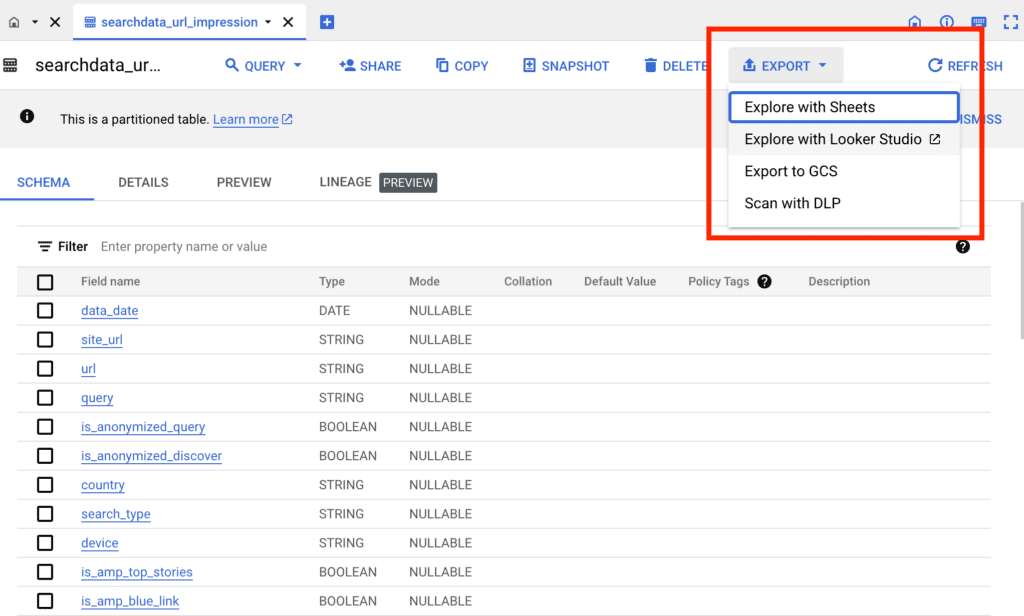

Daten von BigQuery exportieren

Um mit den Daten zu arbeiten, kann man entweder die Daten direkt in BigQuery mit SQL-Befehlen verarbeiten oder die Daten exportieren. Zwei Export-Varianten dürften besonders interessant sein:

- Export in ein Looker Studio: Es wird direkt ein neues Projekt in Looker Studio erstellt. Wenn bereits ein funktionierendes Reporting vorhanden ist, kann dort auf die Datenbank zugegriffen werden.

- Export als CSV: Wenn du es gewohnt bis, mit CSV-Daten zu arbeiten (z.B. mit KNIME), kann BigQuery auf eine (bis zu 1 GB große) CSV im Google Cloud Storage (auch dafür können Gebühren anfallen) ablegen. Das funktioniert wie folgt:

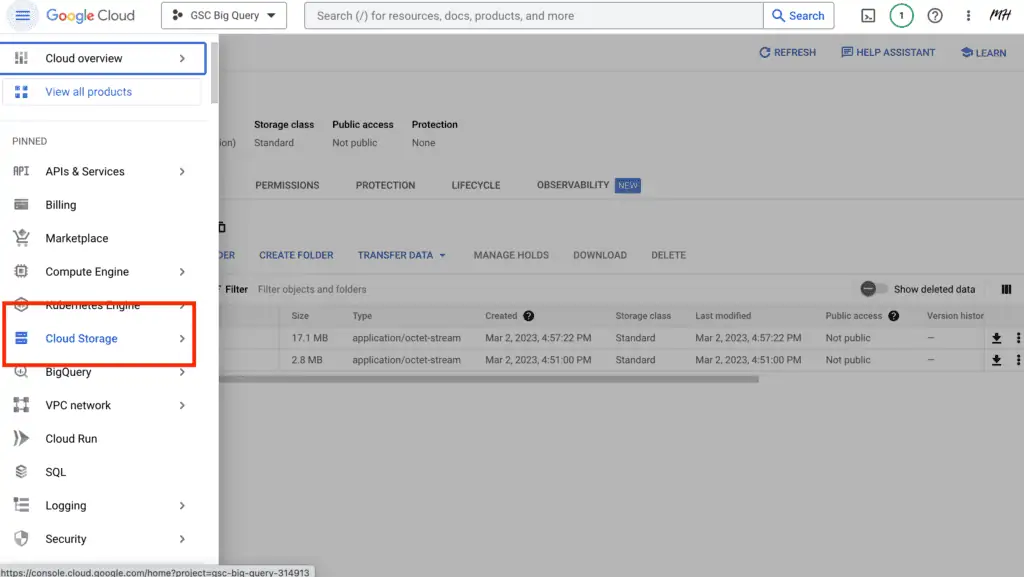

Im Menüpunkt Export wählst du Export to GCS (= Google Cloud Storage). Dort musst du zunächst einen neuen Bucket anlegen, in dem die Daten gespeichert werden. Der Bucket muss in der gleichen Region liegen wie dein Search Console Export (i.d.R. Europäische Union)..

Nun muss noch ein Dateiname vergeben werden und der Export kann gestartet werden. Die CSV-Datei ist dann unter Cloud Storage im Hauptmenü zu finden.

Wir hoffen, dass dir diese Anleitung geholfen hat, deine GSC-Daten erfolgreich nach BigQuery zu exportieren.

Viel Spaß mit einem Google Cloud Projekt.