- Patrick Zeitz

- am

- aktualisiert 29. April 2024

Inhalt

Kurz erklärt: Was ist ChatGPT bzw. ein Large Language Model?

Ganz stark vereinfacht ist ChatGPT eine „Person“ mit der man über alles mögliche sprechen bzw. eben chatten kann. Nur, dass diese „Person“ eine Künstliche Intelligenz (KI) ist, welche auf einen unfassbar großen Wissensschatz zugreifen kann. ChatGPT ist eigtl. auch nur der Produktname von OpenAI (der Firma, welche hinter diesem Modell steht) und man bezeichnet diese Art von „KI“ als Large Language Model kurz LLM – hier mehr dazu.

Interesse? Dann lass uns über die Möglichkeiten eines lokalen Large Language Models Sprechen!

Was kann man mit ChatGPT bzw. einem LLM machen?

Vorweg: Es ist schier unmöglich hier alle Einsatzmöglichkeiten aufzuschlüsseln, weil es einfach in jedem Bereich andere Anforderungen oder Programme gibt, die man automatisieren oder sich zuarbeiten lassen könnte.

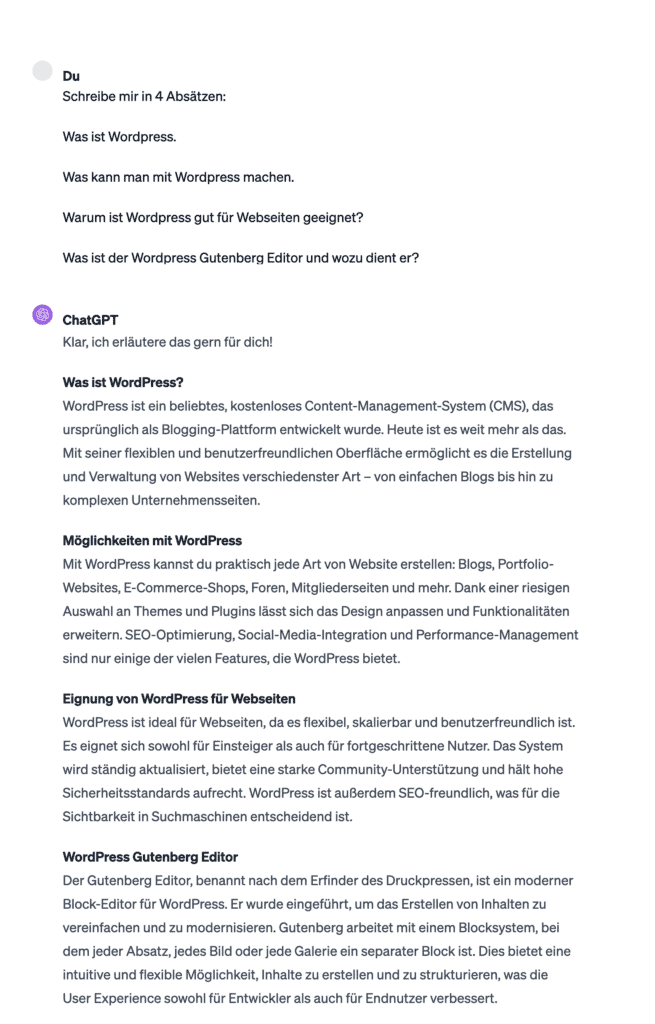

Texte oder Artikel schreiben

Grundsätzlich ist ein Large Language Model (LLM) zur Ausgabe von Texten gedacht und natürlich zum Verstehen „natürlicher“ Sprache in Form von Texteingaben (Prompts).

Deswegen eignen sich diese hervorragend zum Erstellen von Texten, Artikeln, News oder Produktbeschreibungen. Hier kommt es aber auch sehr stark darauf an, wie gut man promptet, da sonst wirklich nur viel generisches Bla Bla herauskommt. Also immer schön viel Informationen bzw. Kontext liefern, dann klappt es auch mit den LLM’s 🙃

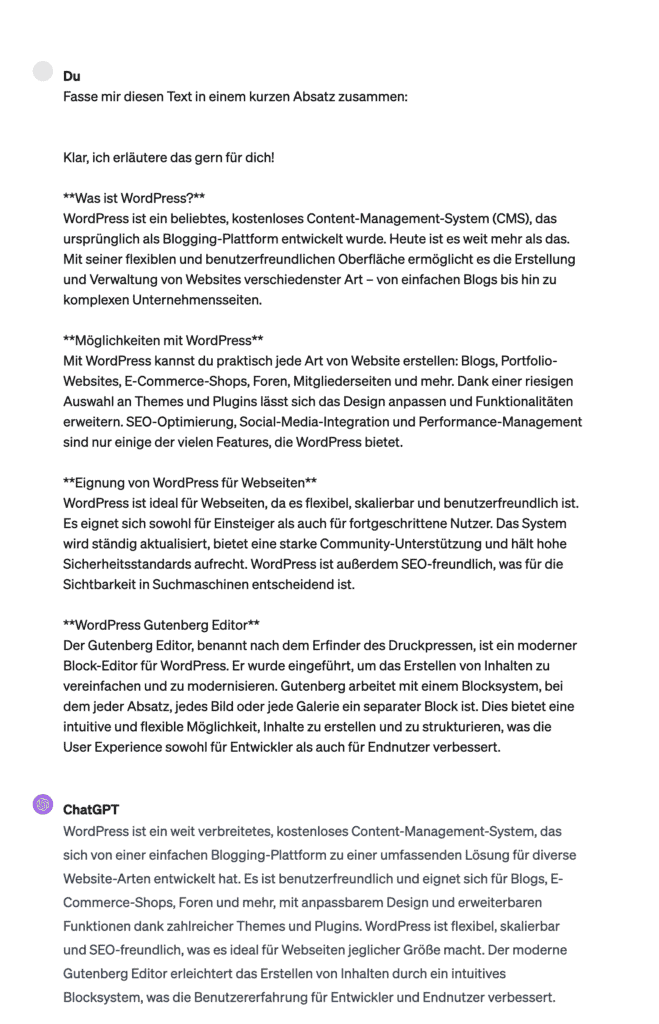

Texte Zusammenfassen

Sehr praktisch ist auch die Fähigkeit sehr komplexe Texte wie z.B. Research Papers o. Artikel in einfachen Worten zusammenfassen zu lassen.

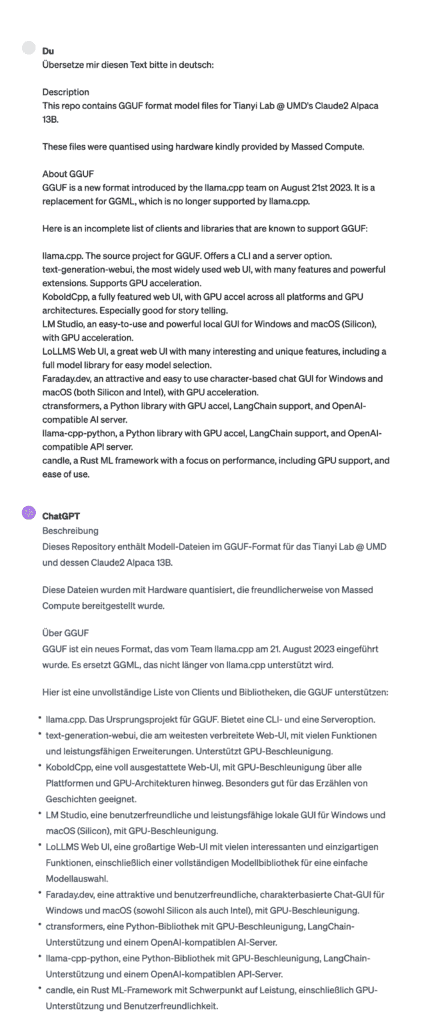

Texte Übersetzen

Einfach den zu übersetzenden Text übergeben (Prompten) und darum bitten diesen in die gewünschte Sprache zu übersetzen – klappt zumindest bei LLM’s die nicht auf eine bestimmte Sprache trainiert wurden. Sehr mächtig und natürlich extrem nützlich, aber schlecht für die menschlichen Übersetzer:innen …

Programmieren

Das macht einer:m Anfänger:in oder auch Senior das Leben wirklich sehr viel leichter.

Es ist fast schon egal, was man wissen möchte, es wird fast alles abgedeckt. Und selbst wenn das LLM diesen speziellen Fall nicht kennt oder lösen kann, dann kann man immer noch die Dokumentation übergeben und sich so vorarbeiten.

Nun sind aber auch viele Menschen, die noch nie etwas mit Programmieren am Hut hatten in der Lage einfache Anwendungen zu Entwickeln.

Fehler finden

Man kann zum Beispiel einen von sich geschriebenen Text übergeben und fragen, ob hier Grammatikfehler vorliegen, oder natürlich auch eine Funktion und nachfragen ob man hier etwas verbessern kann oder ob es evtl. Sicherheitslücken gibt.

Vorschläge für diverse Dinge erhalten

Einfach einen gewissen Kontext (Informationen) übergeben und dann nachfragen, was das LLM für Vorschläge dazu hat. Man könnte z.B. zu einem Firmennamen Brainstormen 🤷🏻♂️

Firmenname, Unterstützung zur Namensfindung:

Ich gründe gerade eine Firma, diese bietet folgende Dienstleistungen an:

- Lorem Ipsum

- Lorem dolor sit

- Lorem ipsum dolor sit amet

Mache mir 30 Vorschläge wie ich diese Firma nennen könnte.

Idealerweise gibt man noch mehr Kontext ein, so dass das LLM wirklich richtig damit arbeiten kann.

ChatGPT richtig verstehen und für deine Firma nutzen! Das bieten wir dir in unseren Workshops an und natürlich vieles mehr.

Potentiale erkennen, Large Language Models (LLM’s / ChatGPT) verstehen, Keywords recherchieren, Texte schreiben, Bilder generieren, Programmieren: Wir zeigen dir wie Du dies alles mit ChatGPT bzw. lokalen LLM’s schneller umsetzen kannst!

Tools die ChatGPT’s API nutzen

Es gibt auch einige StartUp’s die komplett auf der ChatGPT API (Schnittstelle) basieren und somit eigene Entwicklungen mit ChatGPT kombinieren und somit noch mehr Mehrwert liefern können. Hier ein paar davon:

Ein richtig praktisches Tool für den Mac, holt ChatGPT direkt als APP auf den Mac.

Hier lädt man ein PDF hoch und kann dann damit chatten!

Eine Suchmaschine, die Antworten auf Suchanfragen gibt. So wie Google das mal gemacht hat und nun immer mehr Unsinn ausspuckt.

Chrome Extension, welche sich direkt in ChatGPT integriert und viele Funktionen hinzufügt.

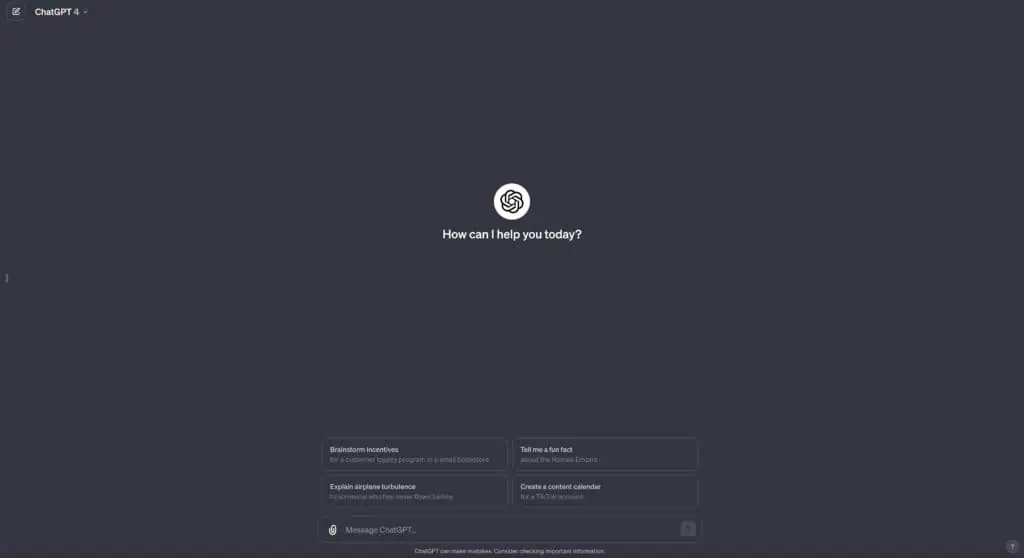

Warum überhaupt eine Alternative zu ChatGPT nutzen?

ChatGPT kann doch alles, was ich brauche, und mit den verfügbaren Tools kann ich ja noch viel mehr machen, warum sollte ich also überhaupt den „beschwerlichen“ Weg der lokalen LLM’s beschreiten?

Ganz einfach:

Datenschutz! (weitere findest Du unten)

Schon wieder unser aller Lieblingsthema „Datenschutz“?

Ja, zurecht ‼️

Alles was man mit ChatGPT oder anderen verfügbaren LLM-Chats teilt, wird mit den dahinterstehenden Firmen geteilt! Lädt man also eine Excel-Datei hoch in welcher z.B. die Umsätze der vergangenen Jahre stehen und fragt:

Erstelle mir eine Übersicht, womit wir in den letzten Jahren am meisten Umsatz und Verlust gemacht haben und stelle mir auf dieser Basis einen Businessplan für das nächste Jahr zusammen.

Dann sind alle Daten in diesen Modellen gespeichert und im schlimmsten Fall können diese dann irgendwann missbraucht werden. Einige Firmen haben auch direkt eine Anweisung an ihre Mitarbeiter herausgegeben diese LLM-Chats NICHT zu nutzen, da hier Geschäftsgeheimnisse abfließen könnten.

Denn man muss ja z.B. ChatGPT erst mit den entsprechenden Daten „trainieren“, also ein paar Texte oder PDF’s hochladen aus denen dann wiederum der notwendige Kontext abgeleitet werden kann.

Praktisches Anwendungsszenario für ein lokales Large Language Model (LLM)!

Stell dir ein hypothetisches Unternehmen vor, das 15 Mitarbeiter:innen in der Produktion und 2 im Support beschäftigt. Der Support muss regelmäßig bei der Geschäftsleitung und der Produktion nachfragen, da trotz ihres umfangreichen Wissens und ihrer Expertise nicht alle Bereiche abgedeckt werden können.

Die Auftragslage ist Gut und die Produktion läuft auf Hochtouren. Daher sind die ständigen Nachfragen des Supports zwar notwendig, aber oft eine Ablenkung und stressig für die Mitarbeiter:innen und die Geschäftsleitung, da sie immer wieder aus ihrer Arbeit herausgerissen werden.

Früher hätte man vielleicht vorgeschlagen, die häufigsten Fragen auf der Webseite im FAQ-Bereich zu beantworten – aber wir alle wissen, dass diese Informationen oft übersehen bzw. einfach ignoriert werden…

Aber was, wenn es eine Möglichkeit gäbe, Kundenanfragen so zu beantworten, dass die Kunden nicht einmal merken, dass sie mit einer KI und nicht mit einem Menschen kommunizieren?

Hier kommt das Large Language Model (LLM) ins Spiel, sei es ChatGPT, Claude2 oder ein eigenes, lokal oder auf einem Server laufendes LLM.

Du kannst ein LLM mit eigenen Daten trainieren, sei es Nutzerfragen, -problemen, -hinweisen oder sogar vollständigen Bedienungsanleitungen von selbst entwickelten Geräten oder Maschinen, die unzählige Tipps und Tricks enthalten.

Diese Daten sind oft in den Köpfen einzelner Teammitglieder verborgen oder in nicht durchsuchbaren PDFs gespeichert. Wenn jedoch all diese Informationen in einem LLM vorhanden bzw. trainiert sind, das Zusammenhänge herstellen kann, erhältst du ein hochspezialisiertes System, das sehr komplexe Anfragen beantworten und gleichzeitig das Team und die Geschäftsleitung entlasten kann.

Was sind die Vorteile eines lokalen LLM?

Natürlich in erster Linie der Datenschutz, es gibt aber noch mehr, z.B.:

- Geschwindigkeit

- Kontrolle

- Trainieren mit eigenen Daten

- Kosten

Was sind die Nachteile eines lokalen LLM?

- Kosten

- Nicht mit so vielen Daten wie ChatGPT trainiert

- Wartung

- Ressourcenhungrig (RAM, Prozessor, Grafik)

Warum habe ich den Punkt „Kosten“ auf beiden Listen stehen?

Die Verwendung von z.B. ChatGPT oder ChatGPT API verursacht Kosten, aber natürlich ist die Nutzung eines lokalen LLM’s nicht kostenfrei. Auf Dauer ist es allerdings kostengünstiger, wenn alles eingerichtet und natürlich trainiert ist.

Überblick

Ich versuche einmal kurz auf alle Punkte der Vor- und Nachteile einzugehen, damit man einen besseren Überblick hat:

Geschwindigkeit

Das ist ein klarer Vorteil, da das lokale LLM natürlich nicht durch die „Leitung“ gepresst werden muss und immer auf eine Serverantwort warten muss – oder gar im schlimmsten Fall z.B. ChatGPT down ist …

Kontrolle

Man hat die komplette Kontrolle über das LLM und kann es sich so einstellen und anpassen wie es eben für den Anwendungsfall sinnvoll ist.

Trainieren

Durch das Trainieren von eigenen Daten ist das lokale LLM höchst effizient und ist so in der Lage, auch die kompliziertesten Anfragen korrekt und evidenzbasiert zu beantworten.

Größe der LLM’s

Anbieter wie OpenAI haben natürlich andere Ressourcen um Ihre LLM’s zu trainieren und können so eine größere Wissensbasis zur Verfügung stellen. Das bedeutet allerdings nicht, dass die lokalen LLM’s schlechter sind.

Wartung

Immer wenn man etwas selbst unter Kontrolle haben möchte, geht dies natürlich mit Problemen einher und diese müssen dann gelöst werden – Stichwort Wartung.

Ressourcen

Der Elefant im Raum! Die Ressourcen sind das größte Problem, können zwar relativ einfach gelöst werden – verursachen aber natürlich erst einmal Investitionskosten.

Ich habe aktuell auf meinem Macbook Pro 16″ M1 Pro 16GB von 2021 ein LLM von META (LLAMA 2) laufen, dies basiert auf 13 Billionen Parametern (mehr dazu unten) und dies läuft schon sehr performant auf dieser Kiste.

Hier noch ein kleiner Exkurs zur Funktion eines LLM und was es mit den Parametern auf sich hat

Große Sprachmodelle (Large Language Models, LLMs) sind maschinelle Lernsysteme, die darauf trainiert sind, menschliche Sprache zu verstehen und zu generieren. Sie basieren auf künstlichen neuronalen Netzwerken, insbesondere auf einer Art namens Transformer – hier muss ich wirklich auf Wikipedia verweisen, ich weiß einfach nicht, wie man es besser erläutern könnte.

Diese Modelle lernen aus großen Mengen von Textdaten, die sie während des Trainingsprozesses analysieren.

Die „Parameter“ in diesen Modellen sind im Grunde genommen die Variablen, die das Modell während des Trainings lernt. Jeder Parameter ist eine Art von „Gewicht„, das angibt, wie stark verschiedene Eingabeinformationen das Ergebnis beeinflussen. Wenn wir also von Modellen mit 7 Billionen, 13 Billionen oder 33 Billionen Parametern sprechen, beziehen wir uns auf die Anzahl der individuellen Gewichte, die das Modell während des Trainingsprozesses lernt und anpasst.

Je mehr Parameter ein Modell hat, desto mehr „Kapazität“ hat es, um Informationen zu lernen und zu speichern. Ein Modell mit mehr Parametern kann in der Regel komplexere Muster und Zusammenhänge in den Daten erkennen, die es analysiert. Allerdings bedeutet eine größere Anzahl von Parametern auch eine größere Rechenlast und die Gefahr des „Overfitting“, bei dem das Modell zu sehr auf die Trainingsdaten abgestimmt ist und nicht gut auf neue, unbekannte Daten reagiert.

Es ist wichtig zu beachten, dass die Anzahl der Parameter nicht unbedingt die Qualität oder Nützlichkeit eines Modells bestimmt. Es geht darum, das richtige Gleichgewicht zwischen Modellgröße, Rechenleistung, Genauigkeit und Anwendbarkeit zu finden.

Arbeitszeit für sich oder Mitarbeiter:innen freischaufeln mit LLM’s? Ja, das funktioniert und wir zeigen dir wie es funktioniert!

Welche Alternativen zu ChatGPT gibt es lokal?

In den letzten Monaten sind so unfassbar viele LLM’s aufgetaucht die aus den verschiedensten Gründen entwickelt bzw. trainiert wurden.

Meist basieren diese allerdings auf LLAMA, LLAMA 2, Meta Llama 3, StableLM, Phi-1 und anderen.

Was heißt nun aber „basieren“? Nun, man kann wie schon erwähnt diese LLM’s weiter trainieren und diese so auf andere Dinge spezialisieren z.B. Code! Hier einmal ein paar davon:

Dieses LLM basiert auf Llama.

Dieses LLM basiert auf CodeLlama und ist auf Python spezialisiert.

Dieses LLM basiert ua. auf Llama.

Wie kann ich ein LLM lokal nutzen?

Das ist mittlerweile relativ „einfach“ geworden 😬

Es gibt z.B. App’s:

oder per Kommandozeile installieren und per UI bedienen:

- Ollama mit Ollama WebUI (Docker)

- Text Gen WebUI

- PrivateGPT

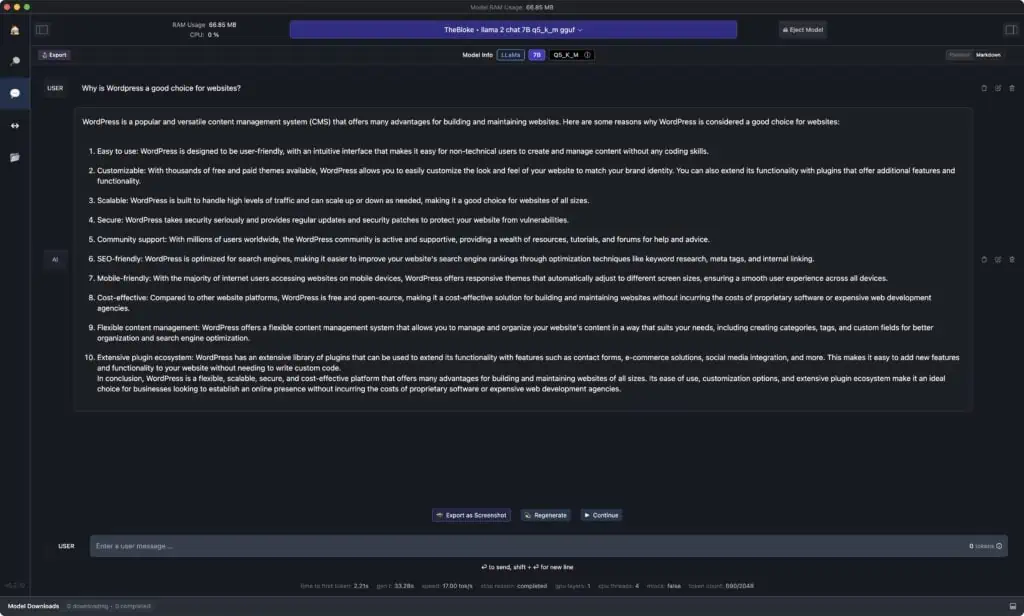

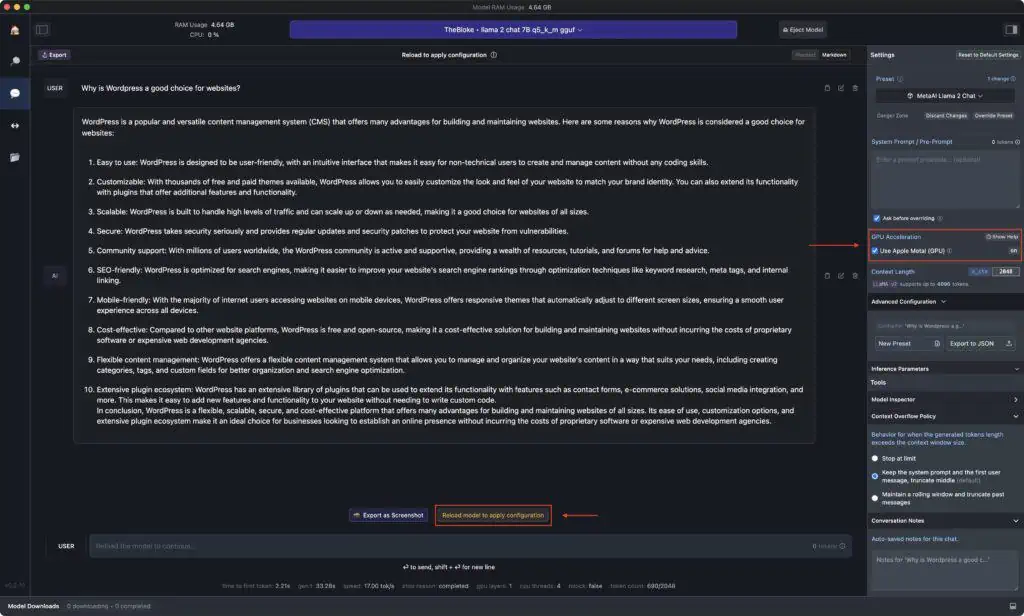

Ausprobiert habe ich Ollama WebUI via Docker und LM Studio auf meinem Macbook Pro M1 Pro 16GB von 2021, wobei Ollama WebUI unfassbar langsam war und LM Studio gleich schnell bzw. schneller als ChatGPT läuft. Ich weiß auch, woran es liegt: Apple bietet mit Metal eine Schnittstelle für grafikintensive Programme an und hier punktet LM Studio, da sie direkt darauf zugreifen. Ollama WebUI sollte das auch können, aber ich habe es nicht geschafft – war aber sicherlich mein Fehler.

Wenn Du also einen Mac mit M1/M2 oder gar M3 hast, dann sollte es überhaupt kein Problem für dich sein einmal etwas mit LM Studio oder Faraday herum zu probieren.

Falls Du allerdings mit Windows unterwegs bist, brauchst Du eine potente Grafikkarte mit mind. 6GB VRAM von NVIDIA oder AMD. Da jedes Setup individuell ausfällt ist es wichtig, hier selbst auszuprobieren was funktioniert und was nicht. Ich bin gar nicht in der Windowswelt unterwegs, probiere und recherchiere hier bitte selbst etwas 🙃

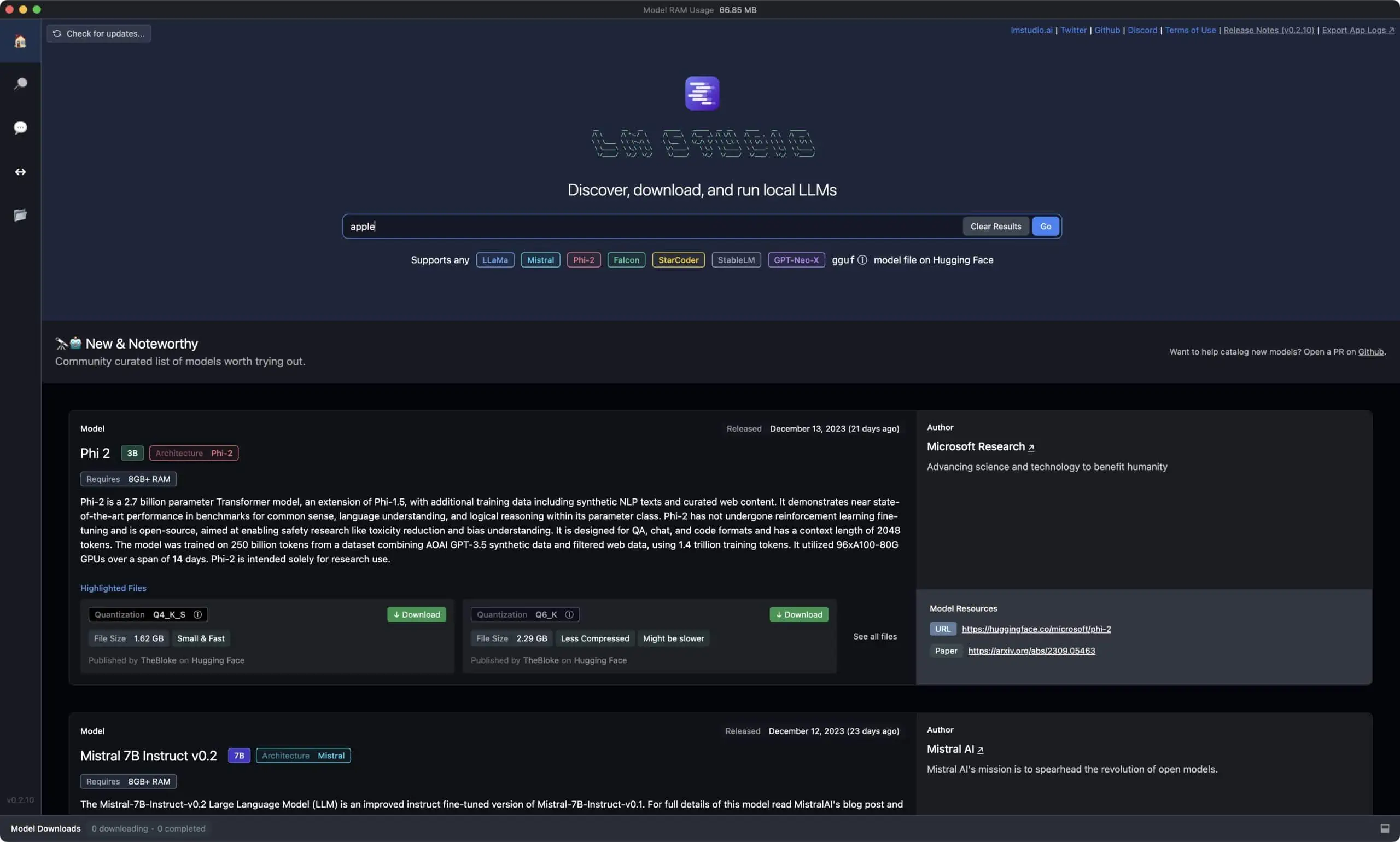

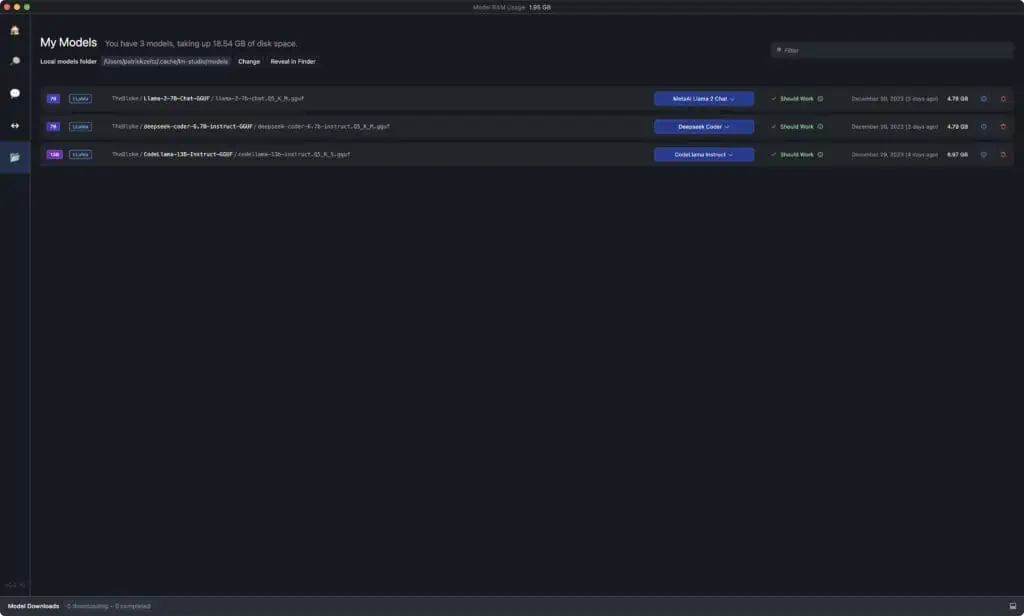

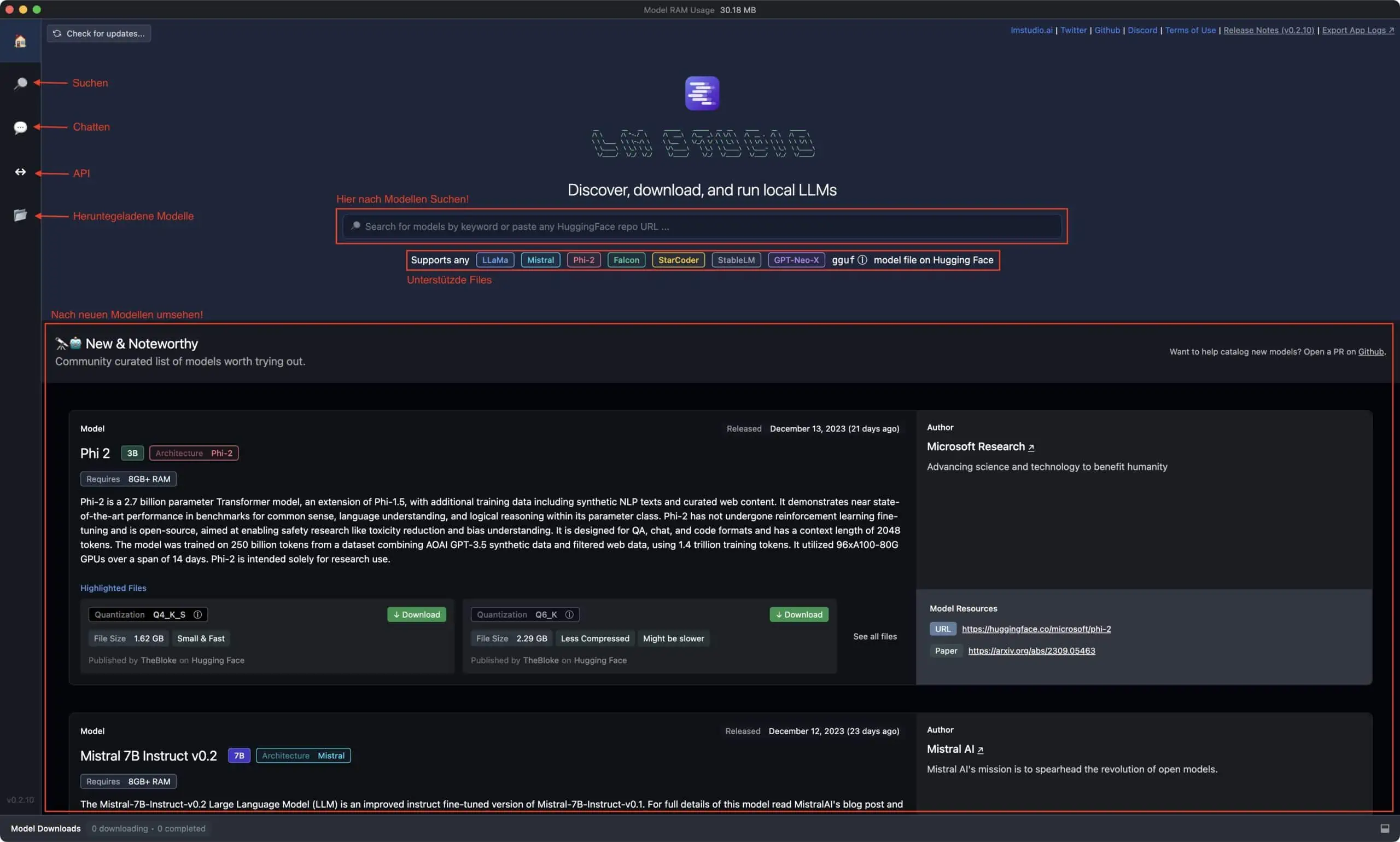

LM Studio Übersicht

Für meine Tests habe ich wie schon geschrieben LM Studio verwendet, welches Du dir hier herunterladen kannst und ganz normal installierst.

Nach dem ersten Start von LM Studio landet man im „Dashboard“ dort bekommt man einen Überblick bzw. ein paar Infos – einfach auf das Bild Klicken, dann wird es größer 🕵️♂️

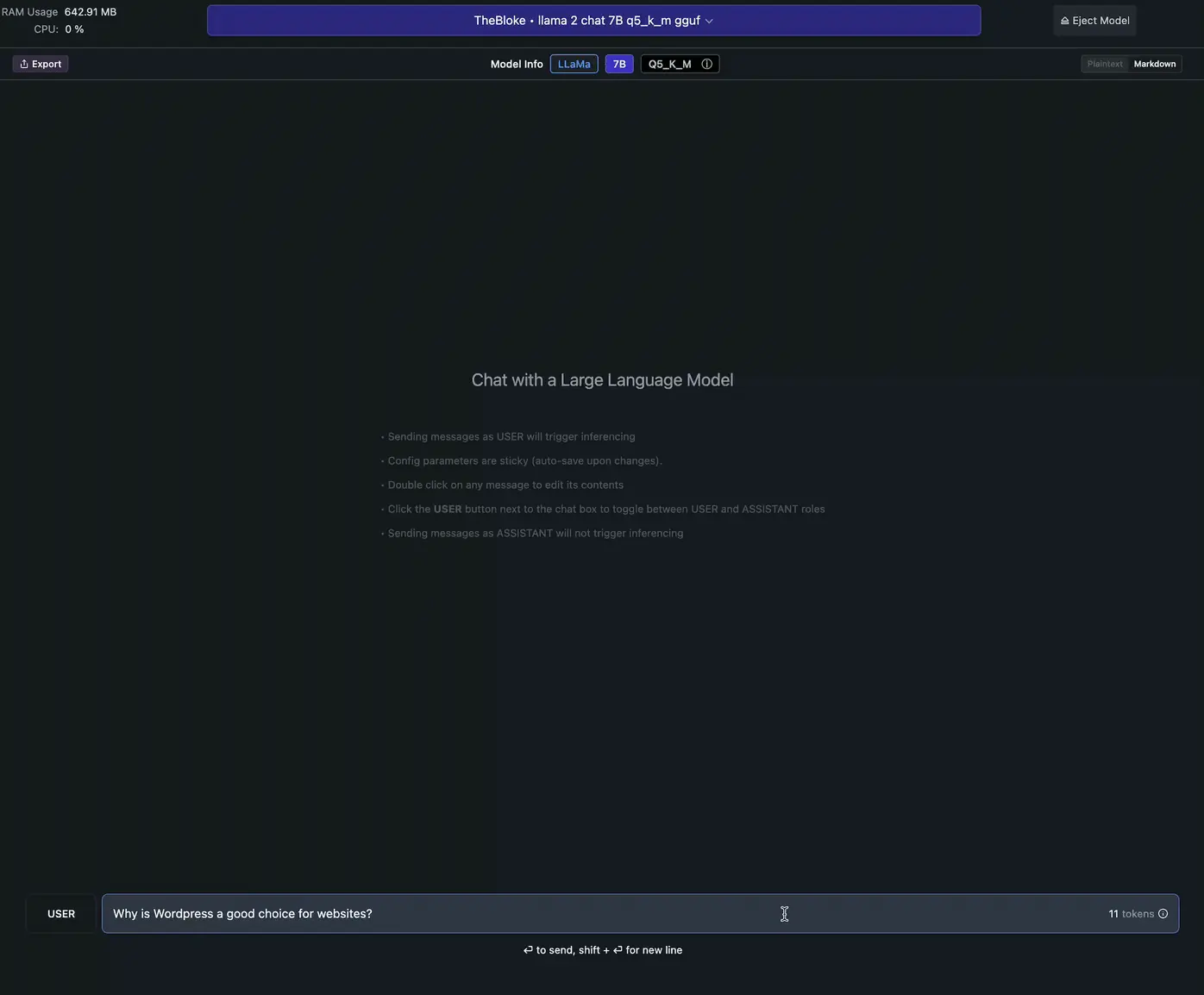

Mit LM Studio LLM’s lokal nutzen und auch herunterladen

Dieses Programm bzw. App ist krass 😳, mich hat am meisten die Geschwindigkeit umgehauen, weil ich vorher Ollama WebUI via Docker laufen hatte und da hatte eine Antwort schonmal 10 Minuten gedauert oder das ganze Ding ist abgesoffen, weil mein Mac komplett am Anschlag lief, weil nur die CPU und nicht die Grafikkarte verwendet wurde.

Man sieht auf dem GIF, in Echtzeit wie schnell eine Antwort ausgegeben wird – für mich beeindruckend.

Gerade wenn man bedenkt, dass hier alles Lokal auf meinem Mac läuft!

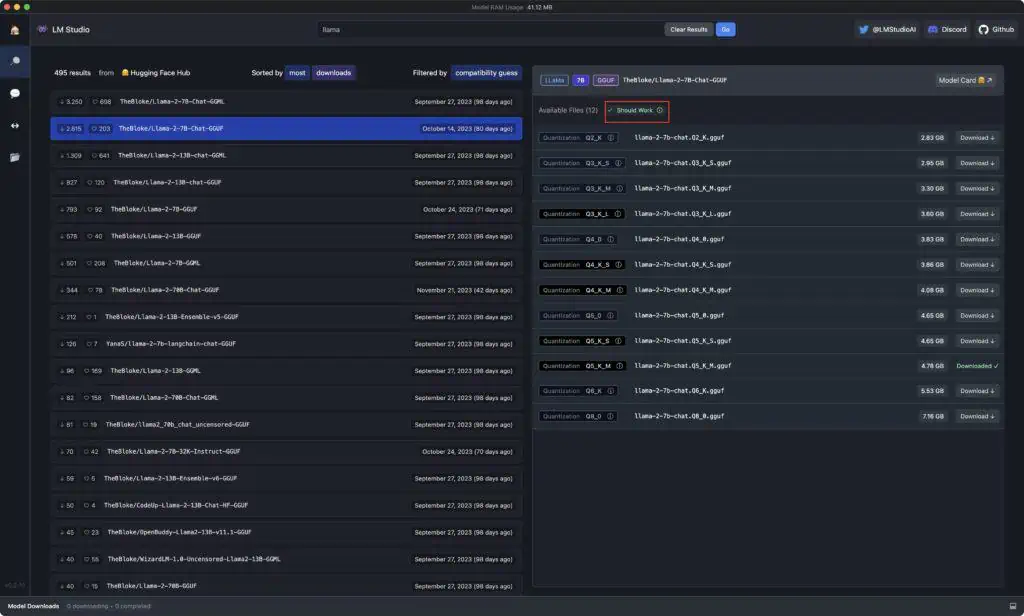

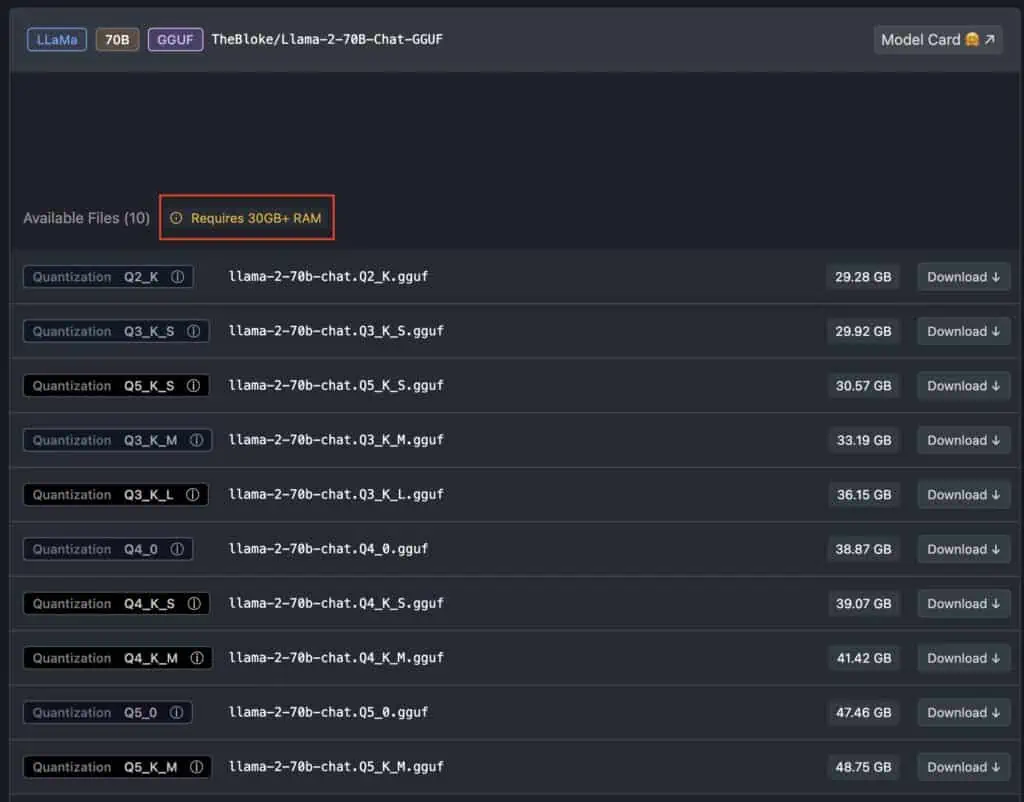

LLM’s finden

Mit LM Studio geht das ziemlich einfach, da man hier einfach direkt in der App die entsprechenden LLM’s herunterladen kann und zusätzlich wird hier noch angezeigt, ob die eigene Hardware im Stande ist, das LLM auszuführen – mehr zu meinen getesteten LLM’s unten:

Oder eben nicht 😵💫

Wenn Du einen Mac verwendest, dann achte darauf, dass METAL aktiviert ist und Klicke auf Reload Model:

Diese LLM’s kann ich zum Ausprobieren empfehlen

Ich habe jetzt schon ein paar ausprobiert und Liste sie dir hier auf, am besten ist es aber, wenn Du dich selbst ausprobierst und schaust, was am besten zu dir passt und auf deiner Hardware auch wirklich läuft – Stichwort Parameter und Rechenleistung!

LLAMA 3 (Model Card)

Als Chat nutzbar, antwortet recht akkurat auf Anfragen. Halluziniert aber auch schon gerne einmal … so wie man es im Großen und Ganzen gewohnt ist.

LLAMA 2 Chat (Model Card)

Als Chat nutzbar, antwortet recht akkurat auf Anfragen. Halluziniert aber auch schon gerne einmal … so wie man es im Großen und Ganzen gewohnt ist.

Mistral (Model Card)

Auch als Chat nutzbar, gleiches wie bei LLama 2.

Alpaca (Model Card)

Auch als Chat nutzbar, gleiches wie bei LLama 2.

OpenChat (Model Card)

Hier habe ich kaum getestet, probiere es einfach aus 😬

CodeLlama (Model Card)

Richtig gut im Coding!

DeepSeekCoder (Model Card)

Evtl. sogar noch besser im Coding, hier muss ich noch mehr Tests aufsetzen.

Hier findet man noch mehr LLM’s:

- 8 Top Open-Source LLMs for 2024 and Their Uses | DataCamp

- GitHub – Hannibal046/Awesome-LLM: Awesome-LLM: a curated list of Large Language Model

- GitHub – eugeneyan/open-llms: 📋 A list of open LLMs available for commercial use.

- Best Open Source LLMs: Comprehensive Guide to Testing, Running, and Selecting — Klu

Wenn ich mir ein Model wünschen könnte, dann ein auf WordPress spezialisiertes!

Ich kann dir ebenfalls empfehlen auf YouTube nach „Local LLM“ oder „Best Local LLM“ zu suchen, da verliert man sich dann zwar irgendwann im berühmten Kaninchenbau 🐇, aber ist danach definitiv noch verwirrter 😧 als vorher – wer traut sich?

GPT4ALL Übersicht

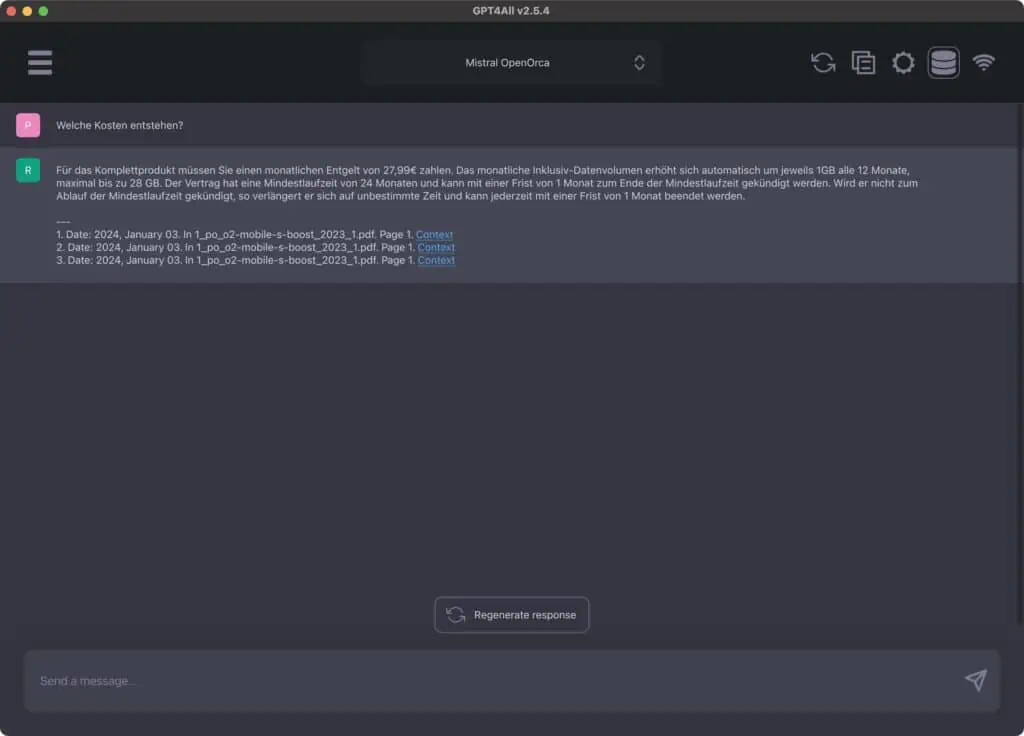

Und dann habe ich noch GPT4ALL ausprobiert, welches Du hier herunterladen und ebenfalls einfach installieren kannst. Hier kann man wohl nicht so viele Modelle herunterladen, wie bei LM Studio, dafür ist es möglich hier Datei-Kollektionen anzulegen und so mit PDF’s bzw. Dokumenten zu chatten!

Mit Dokumenten chatten

Als Dokument habe ich einfach eine Preisliste von o2 hinterlegt und dann nach den Kosten gefragt 😅

Wichtig, es muss erst ein PlugIn heruntergeladen werden:

Settings -> LocalDocs -> SBert -> Collection Name -> Path -> Add

=> Im Chat auf das Symbol neben den Einstellungen klicken und die Kollektion auswählen und einfach nachfragen!

So könnte man z.B. für seine Kunden oder sich selbst einzelne Ordner (Datei-Kollektionen) anlegen und so ganz einfach an alle notwendigen Informationen gelangen! Oder wenn man z.B. ein Buch oder eine Dokumentation hat und daraus Informationen braucht, könnte man einfach danach fragen!?

Sicherlich praktisch für Recherchen o.Ä.

Ressourcen

Da ich einiges an Material gesammelt habe findest Du hier einmal ein paar Links zu Beiträgen oder Video’s, welche ich mir angesehen habe und für erwähnenswert erachte:

Beiträge

- Large Language Models erklärt: Was sind LLMs? – computerwoche.de

- GitHub – continuedev/what-llm-to-use: 👀 What LLM to use? A perspective from the DevAI space

- 6 main differences between Llama 2, GPT-3.5 & GPT-4 | Neoteric

- 5 easy ways to run an LLM locally | InfoWorld

- Run LLMs locally | 🦜️🔗 Langchain

- 6 Ways to Run LLMs Locally (also how to use HuggingFace) (semaphoreci.com)

- Five Ways of Running Large Language Models (LLMs) Locally (November 2023) (kleiber.me)

Videos

- LMStudio Tutorial 🚨 Run ANY Open-Source Model LOCALLY

- KOSTENLOSE KI-Modelle einfach verwalten und LOKAL nutzen! | LM Studio Tutorial

- Replace OpenAI API with local models: Ollama + LiteLLM, text gen webui, google colab

- Ollama Web UI 🤯 How to run LLMs 100% LOCAL in EASY web interface? CRAZY!!🚀 (Step-by-Step Tutorial)

- Using ChatGPT with YOUR OWN Data. This is magical. (LangChain OpenAI API)

- Alpaca Turbo – NEW ChatGPT-like UI For LOCAL Models (Tutorial)

Fazit und Gedanken

Manchmal frage ich mich, wie ich auf diese Themen komme, aber hier liegt es ganz klar an Stable Diffusion – hier liest Du mehr darüber.

Dadurch habe ich erst gemerkt welche Möglichkeiten sich daraus ergeben könnten:

Wir könnten z.B. für einen Kunden sein komplett eigenes LLM trainieren und so dazu beitragen die Arbeitszeit der Mitarbeiter:innen signifikant freizuschaufeln, so dass diese mehr Zeit für die wichtigen Dinge haben. Das würde natürlich auch zu mehr Umsatz und Mitarbeiterzufriedenheit beitragen.

Man stelle sich nur vor, wie eine 4.000 Seiten starke Dokumentation von einem Kunden durchforstet werden muss, um dann herauszufinden, dass die gesuchte Information da gar nicht vorzufinden ist, weil sie sich in Anlage 2b im Absatz 35 befindet und dieser dann wiederum auf Anlage 3 verweist – wunderbar … 😅 🤷🏻♂️

Abgesehen davon, wie schlecht das PDF o.ä durchsuchbar sind und manche PC’s oder Mac’s einfach den Dienst quittieren, weil das Dokument einfach zu groß ist.

Wenn man aber nun ein LLM lokal mit allen nötigen Informationen sowie Problemen und deren Lösungen füttert, würde das LLM Verbindungen zwischen Anfrage und Fehler erkennen können und diese dem Kunden in kürzester Zeit zur Verfügung stellen können.

Das Ganze ist unglaublich faszinierend und wird unser Leben noch mehr beeinflussen als es das letzte Jahr eh schon getan hat.

Auf vielen Webseiten sind seit Jahren ChatBots für Kundenanfragen implementiert, die waren ja aber wirklich ziemlicher Mist und wirklich nicht hilfreich – das hat sich jetzt aber komplett geändert! Auch auf unserer Seite befindet sich unten rechts ein Chat (ChatGPT API) bei dem man nach Infos von unserer Seite fragen kann – funktioniert tatsächlich, einfach einmal ausprobieren. 😊